Web crawler là gì? Cách tối ưu website để tăng hiệu thu thập thông tin website

Web crawler truy cập URL, đọc nội dung, theo backlink để thu thập dữ liệu và xây dựng cơ sở dữ liệu khổng lồ. Hiểu cách crawler hoạt động và tối ưu website giúp cải thiện hiệu suất thu thập dữ liệu, hỗ trợ SEO. Các yếu tố quan trọng gồm cấu trúc URL, nội dung chất lượng, tốc độ tải trang và khả năng xử lý nội dung động. Nội dung này sẽ phân tích cách thức hoạt động, vai trò, các loại crawler phổ biến và yếu tố tối ưu để crawler thu thập dữ liệu hiệu quả hơn.

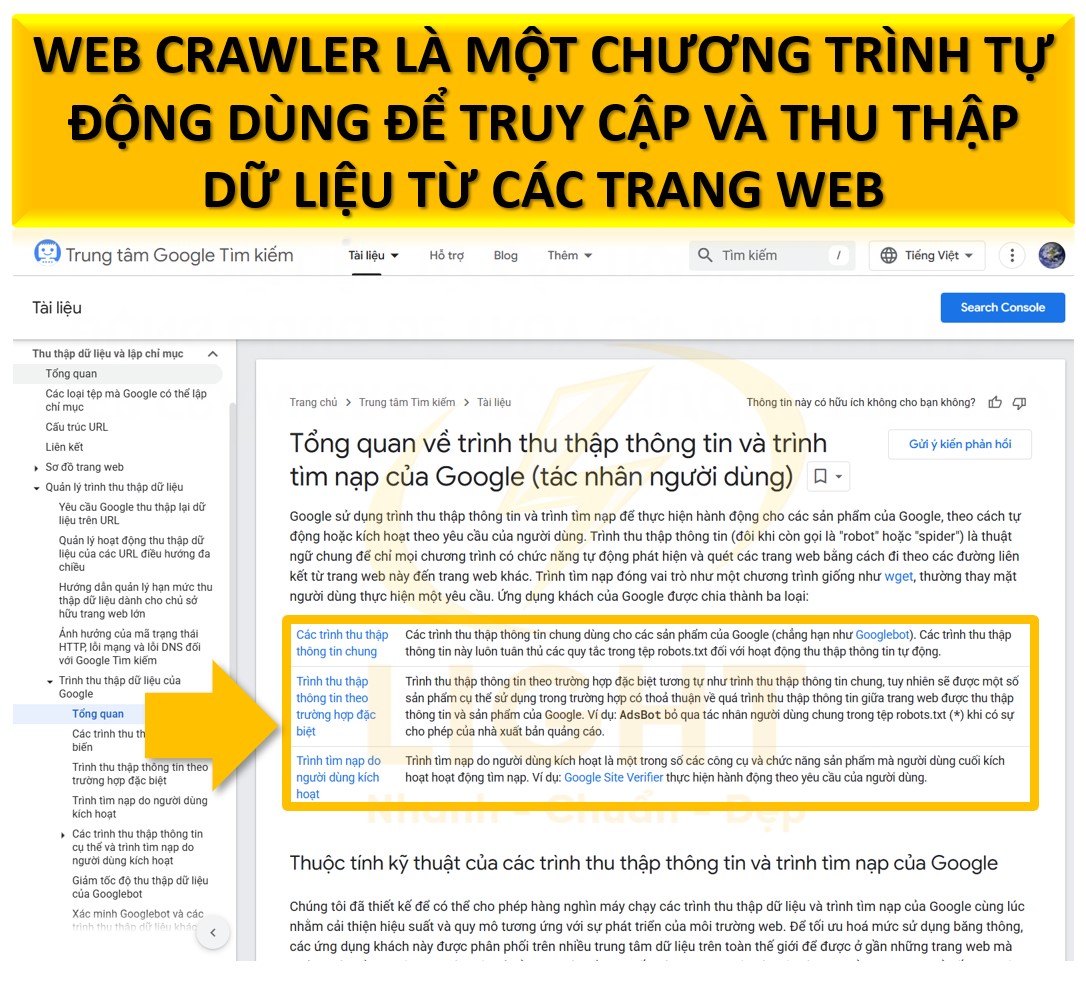

Web Crawler là gì?

Web Crawler (hay còn gọi là bot hoặc spider) là một chương trình tự động dùng để truy cập và thu thập dữ liệu từ các trang web. Công cụ này được thiết kế để duyệt qua các trang, đọc nội dung và lưu trữ thông tin. Mục đích của web crawler thường là giúp các công cụ tìm kiếm như Google lập danh sách các trang web (index) hoặc hỗ trợ thu thập thông tin phục vụ nghiên cứu và phân tích.

Cách hoạt động cơ bản của web crawler:

- Bắt đầu từ một URL ban đầu.

- Đọc nội dung trang đó.

- Theo các đường liên kết để tiếp tục truy cập đến các trang khác.

Crawler có thể được lập trình để tập trung vào một loại dữ liệu cụ thể hoặc tuân thủ các quy định mà trang web đưa ra (ví dụ: tệp robots.txt). Với vai trò quan trọng trong nhiều lĩnh vực như công cụ tìm kiếm, nghiên cứu thị trường, kiểm tra website và ứng dụng trí tuệ nhân tạo, web crawler giúp tối ưu hóa quy trình làm việc, tiết kiệm thời gian và nâng cao hiệu quả. Ngoài ra, các loại web crawler đa dạng cũng được thiết kế để đáp ứng những mục tiêu cụ thể, từ lập chỉ mục nội dung đến lưu trữ dữ liệu dài hạn.

Vai trò của web crawler trong việc thu thập dữ liệu website

Web crawler đảm nhiệm nhiều vai trò quan trọng trong việc thu thập và xử lý dữ liệu từ các trang web, giúp tăng hiệu quả và tiết kiệm thời gian so với các phương pháp thủ công. Theo nghiên cứu của Brin và Page (1998) trong ‘The Anatomy of a Large-Scale Hypertextual Web Search Engine’, crawler là thành phần cốt lõi giúp duy trì tính toàn vẹn và cập nhật của dữ liệu công cụ tìm kiếm. Dưới đây là các vai trò cụ thể:

1. Công cụ tìm kiếm

Web crawler là công cụ cốt lõi của các công cụ tìm kiếm như Google, Bing, và Yahoo. Các crawler này quét toàn bộ nội dung của các trang web công khai, thu thập dữ liệu như văn bản, hình ảnh, và liên kết. Dữ liệu được phân tích và lập chỉ mục (index) để phục vụ thuật toán xếp hạng, giúp người dùng nhận được kết quả tìm kiếm phù hợp nhất khi nhập từ khóa.Ví dụ: Googlebot là một loại crawler của Google. Nó không chỉ thu thập nội dung mà còn đánh giá các yếu tố như tốc độ tải trang, liên kết nội bộ, và sự thân thiện với thiết bị di động để xác định chất lượng của một trang web.

2. Nghiên cứu thị trường

Các doanh nghiệp sử dụng crawler để thu thập thông tin chi tiết về thị trường như giá sản phẩm, đánh giá của người tiêu dùng, hoặc xu hướng mới nhất. Crawler có thể quét hàng trăm trang thương mại điện tử trong một thời gian ngắn, giúp các công ty nắm bắt nhanh chóng những thay đổi trên thị trường.Ví dụ: Một công ty bán lẻ trực tuyến có thể sử dụng crawler để theo dõi giá cả sản phẩm của đối thủ cạnh tranh và tự động điều chỉnh giá của mình để luôn cạnh tranh.

3. Kiểm tra và tối ưu hóa website

Web crawler cũng được dùng để phân tích và kiểm tra chất lượng của một website. Các lỗi phổ biến mà crawler có thể phát hiện bao gồm:- Liên kết bị hỏng (broken links).

- Nội dung trùng lặp (duplicate content).

- Trang web có tốc độ tải chậm.

- Cấu trúc website không rõ ràng.

Các công cụ kiểm tra website như Screaming Frog hay Ahrefs sử dụng crawler để quét trang web, cung cấp báo cáo chi tiết, giúp chủ sở hữu website sửa lỗi và cải thiện hiệu suất.

4. Dữ liệu cho trí tuệ nhân tạo (AI)

Web crawler là nguồn cung cấp dữ liệu lớn cho các mô hình học máy và trí tuệ nhân tạo. Các hệ thống này cần khối lượng dữ liệu khổng lồ để phân tích, học hỏi, và đưa ra quyết định.Ví dụ: Một công ty phát triển chatbot AI có thể sử dụng crawler để thu thập hàng triệu cuộc trò chuyện từ các diễn đàn trực tuyến, giúp chatbot hiểu ngôn ngữ tự nhiên và tương tác giống con người hơn.

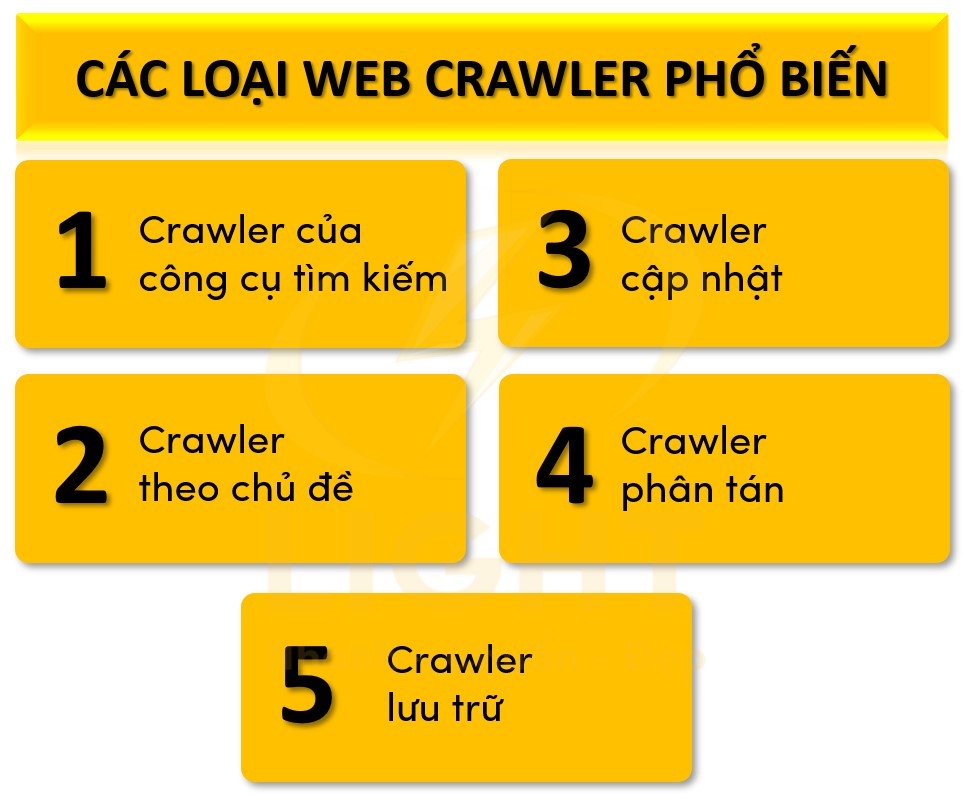

Các loại web crawler phổ biến

Web crawler được phân loại dựa trên mục đích và phương pháp hoạt động. Mỗi loại có cách thức làm việc riêng, phù hợp với từng ứng dụng cụ thể.

1. Crawler của công cụ tìm kiếm

Các công cụ tìm kiếm như Google, Bing sử dụng crawler để quét và lập chỉ mục nội dung trên internet.- Ví dụ: Googlebot, Bingbot.

- Đặc điểm: Thu thập toàn bộ nội dung có thể truy cập công khai, từ đó xếp hạng các trang web dựa trên nhiều yếu tố như nội dung, liên kết, và tốc độ tải trang.

2. Crawler theo chủ đề (Focused Crawler)

Đây là loại crawler chỉ thu thập dữ liệu liên quan đến một lĩnh vực cụ thể.- Ví dụ: Một công ty tài chính sử dụng crawler để thu thập tin tức về thị trường chứng khoán từ các trang tin tức.

- Ứng dụng: Nghiên cứu giá cả, xu hướng, hoặc theo dõi phản hồi của người dùng trong một ngành cụ thể.

3. Crawler cập nhật (Incremental Crawler)

Crawler này tập trung vào việc quét lại những nội dung đã thay đổi hoặc mới được cập nhật, thay vì quét toàn bộ website.- Ví dụ: Một công cụ tìm kiếm nội bộ cho trang tin tức sử dụng crawler để cập nhật bài viết mới nhất mà không cần quét lại các bài viết cũ.

- Ứng dụng: Theo dõi thay đổi nội dung trên website mà không tốn nhiều tài nguyên.

4. Crawler phân tán (Distributed Crawler)

Hoạt động bằng cách chia nhỏ công việc và chạy trên nhiều máy chủ khác nhau, giúp tăng tốc độ thu thập dữ liệu.- Ví dụ: Các tổ chức nghiên cứu khoa học thường sử dụng crawler phân tán để thu thập dữ liệu từ hàng triệu trang web trong thời gian ngắn.

- Ứng dụng: Thu thập dữ liệu với quy mô lớn để phân tích hoặc nghiên cứu.

5. Crawler lưu trữ (Archival Crawler)

Crawler này được thiết kế để thu thập và lưu trữ nội dung của website trong thời gian dài, phục vụ mục đích tra cứu lịch sử.- Ví dụ: Wayback Machine sử dụng crawler để lưu trữ phiên bản cũ của các trang web, cho phép người dùng xem lại trạng thái website tại một thời điểm trong quá khứ.

- Ứng dụng: Bảo tồn nội dung web, theo dõi lịch sử thay đổi của các trang.

Mỗi loại crawler đều có vai trò cụ thể và thường được tối ưu hóa để phục vụ đúng mục tiêu thu thập dữ liệu mà chúng được lập trình.

Cách web crawler hoạt động

Các crawler hoạt động dựa trên những thuật toán phức tạp, cho phép chúng thu thập thông tin một cách có hệ thống và hiệu quả, đồng thời đảm bảo khả năng quản lý tài nguyên thông minh để không gây quá tải cho các server mà chúng truy cập. Chúng cũng được thiết kế để tuân thủ các quy định của từng trang web, bao gồm việc kiểm tra tệp robots.txt hoặc thực hiện các quy tắc ngăn chặn nội dung cụ thể.

Tuy nhiên, hoạt động của web crawler không chỉ giới hạn trong lĩnh vực công cụ tìm kiếm. Nhiều doanh nghiệp và tổ chức sử dụng crawler để phân tích thị trường, giám sát đối thủ cạnh tranh, hoặc thu thập dữ liệu cho các ứng dụng học máy (machine learning). Điều này làm cho web crawler trở thành một công cụ đa năng với tiềm năng ứng dụng lớn, đồng thời tạo ra những thách thức đáng kể về đạo đức và pháp lý liên quan đến việc thu thập dữ liệu.

Việc hiểu rõ cách web crawler hoạt động, bao gồm quy trình thu thập thông tin, cách xử lý dữ liệu, và các yếu tố ảnh hưởng đến hiệu suất của chúng, không chỉ giúp các quản trị viên web tối ưu hóa website mà còn hỗ trợ doanh nghiệp xây dựng chiến lược tiếp cận thông tin hiệu quả hơn.

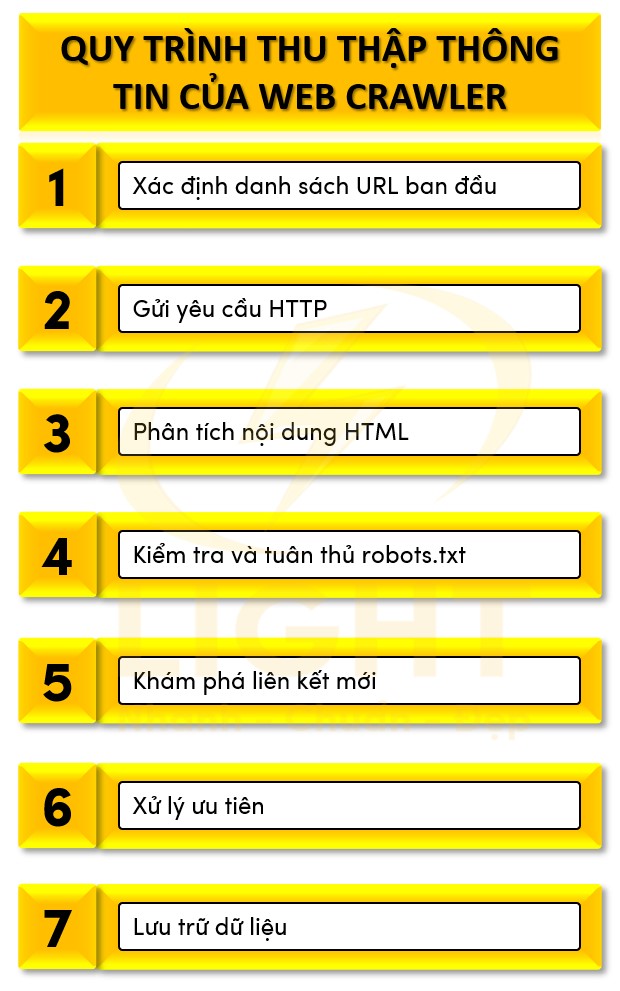

Quy trình thu thập thông tin của web crawler

Xác định danh sách URL ban đầu (Seed URL):

Web crawler bắt đầu từ một tập hợp URL ban đầu, thường là các trang phổ biến hoặc được chỉ định cụ thể. Những URL này có thể được lấy từ cơ sở dữ liệu nội bộ, sitemap của website, hoặc danh sách được cung cấp bởi người dùng.Gửi yêu cầu HTTP:

Crawler sử dụng giao thức HTTP hoặc HTTPS để gửi yêu cầu tới server của trang web. Yêu cầu này thường là GET request, nhằm truy xuất tài nguyên HTML của trang.Phân tích nội dung HTML:

Sau khi nhận được phản hồi từ server, crawler phân tích mã nguồn HTML của trang để trích xuất nội dung, xác định tiêu đề (title), thẻ meta, văn bản, hình ảnh, và các liên kết dẫn đến các trang khác. Phân tích này sử dụng các bộ phân tích cú pháp (parsing libraries) như BeautifulSoup hoặc bộ xử lý DOM.Kiểm tra và tuân thủ robots.txt:

Trước khi thu thập bất kỳ dữ liệu nào, crawler kiểm tra file robots.txt để xác định các quy tắc mà website đặt ra. File này quy định những phần nào của website mà crawler được phép hoặc không được phép truy cập.Khám phá liên kết mới:

Crawler thu thập tất cả liên kết (anchor links) trong trang, bao gồm cả liên kết nội bộ và liên kết ngoài. Mỗi liên kết được đưa vào hàng đợi (queue) để xử lý sau. Quá trình này được tối ưu hóa để tránh trùng lặp bằng cách kiểm tra liên kết đã được thu thập trước đó.Xử lý ưu tiên:

Hệ thống crawler sử dụng thuật toán xếp hạng ưu tiên, như PageRank hoặc các thuật toán heuristic, để quyết định thứ tự thu thập. Các trang có uy tín cao hoặc được liên kết nhiều sẽ được ưu tiên xử lý trước.Lưu trữ dữ liệu:

Sau khi thu thập nội dung, crawler chuyển dữ liệu tới hệ thống lưu trữ và lập chỉ mục. Các thông tin quan trọng được tổ chức lại để dễ dàng tìm kiếm và sử dụng.

Cách web crawler xử lý và lưu trữ dữ liệu

Xử lý dữ liệu:

- Trích xuất thông tin cốt lõi: Nội dung HTML được phân tích để tách biệt tiêu đề, đoạn văn, liên kết, hình ảnh, và các thành phần quan trọng khác.

- Loại bỏ trùng lặp: Crawler sử dụng thuật toán phát hiện trùng lặp như thuật toán hashing để loại bỏ các trang hoặc nội dung trùng lặp.

- Phân loại nội dung: Các thành phần như tiêu đề, meta tags, hoặc văn bản được phân loại dựa trên ngữ cảnh và ý nghĩa. Ví dụ, crawler có thể phân biệt giữa nội dung chính (main content) và các thành phần bổ sung như quảng cáo hoặc menu.

- Xử lý dữ liệu phi cấu trúc: Với các trang sử dụng JavaScript hoặc AJAX để tải nội dung, crawler sử dụng các trình duyệt mô phỏng như Puppeteer hoặc Selenium để thu thập dữ liệu động.

Lưu trữ dữ liệu:

- Tổ chức chỉ mục: Dữ liệu được lưu trữ trong các cấu trúc chỉ mục, giúp hệ thống tìm kiếm truy xuất nhanh chóng. Ví dụ, mỗi từ khóa trong nội dung sẽ được liên kết với URL chứa nó.

- Lưu trữ phân tán: Để xử lý lượng dữ liệu lớn, crawler sử dụng hệ thống lưu trữ phân tán như Hadoop hoặc Cassandra, cho phép chia sẻ và quản lý tài nguyên trên nhiều server.

- Tạo bản sao dự phòng: Dữ liệu được sao lưu để đảm bảo khả năng khôi phục trong trường hợp hệ thống gặp sự cố.

- Nén và tối ưu hóa: Dữ liệu được nén lại bằng các thuật toán nén hiệu quả như gzip để tiết kiệm không gian lưu trữ.

Yếu tố ảnh hưởng đến khả năng thu thập dữ liệu

Cấu trúc trang web:

Trang web được tổ chức tốt với hệ thống liên kết nội bộ rõ ràng sẽ giúp crawler dễ dàng khám phá và thu thập nội dung. Ngược lại, các trang không có liên kết nội bộ hoặc sử dụng JavaScript để tải nội dung sẽ làm giảm khả năng thu thập.Hiệu suất server:

Tốc độ phản hồi của server ảnh hưởng trực tiếp đến số lượng trang mà crawler có thể thu thập trong một phiên. Server chậm hoặc không ổn định có thể khiến crawler gặp lỗi timeout.Quy tắc robots.txt và meta tags:

File robots.txt hoặc thẻ meta robots có thể giới hạn quyền truy cập của crawler. Ví dụ, lệnh "Disallow" trong robots.txt sẽ ngăn crawler thu thập một số trang nhất định.Crawl Budget:

Mỗi website có một lượng tài nguyên thu thập giới hạn, gọi là crawl budget. Crawl budget bị ảnh hưởng bởi mức độ quan trọng của trang web, tốc độ phản hồi, và cấu trúc liên kết.Liên kết hỏng:

Các liên kết dẫn đến trang lỗi 404 hoặc 500 sẽ làm giảm hiệu suất thu thập của crawler và có thể ảnh hưởng đến khả năng lập chỉ mục.Tần suất cập nhật nội dung:

Crawler thường ưu tiên thu thập các trang web có nội dung mới hoặc được cập nhật thường xuyên, trong khi các trang ít thay đổi sẽ bị giảm tần suất truy cập.Yếu tố ngôn ngữ và địa lý:

Một số crawler sử dụng bộ lọc ngôn ngữ hoặc khu vực để tập trung vào nội dung phù hợp. Ví dụ, một trang web có nội dung tiếng Việt sẽ được ưu tiên hơn khi crawler phục vụ đối tượng Việt Nam.Chất lượng sitemap:

Sitemap XML cung cấp thông tin quan trọng về cấu trúc trang web và tần suất cập nhật, giúp crawler xác định thứ tự và tần suất thu thập nội dung. Sitemap không chính xác hoặc thiếu dữ liệu sẽ làm giảm hiệu quả thu thập.Hạn chế từ hệ thống bảo mật:

Một số website sử dụng CAPTCHA hoặc các cơ chế chặn bot để ngăn chặn crawler không mong muốn, điều này cũng ảnh hưởng đến quá trình thu thập dữ liệu.

Tại sao tối ưu website quan trọng cho web crawler?

Tối ưu hóa cho web crawler không chỉ giúp tăng khả năng lập chỉ mục mà còn cải thiện xếp hạng website trên các công cụ tìm kiếm, đồng thời đảm bảo các nội dung quan trọng được truy cập và phân tích đầy đủ. Các yếu tố như cấu trúc website, tốc độ tải trang, liên kết nội bộ, và khả năng xử lý nội dung động đều đóng vai trò quan trọng trong việc nâng cao hiệu quả của web crawler. Đặc biệt, các vấn đề kỹ thuật như robots.txt, sitemap XML hay xử lý nội dung trùng lặp là những yếu tố then chốt để giúp crawler hoạt động trơn tru.

Trong nội dung sau đây, chúng ta sẽ phân tích chi tiết tầm quan trọng của việc tối ưu website cho web crawler, tác động của tối ưu hóa đến quá trình thu thập dữ liệu và cách crawlability liên kết chặt chẽ với SEO.

Các yếu tố cần tối ưu để hỗ trợ web crawler:

Cấu trúc website rõ ràng

- Một cấu trúc phân cấp logic với các danh mục chính và phụ rõ ràng giúp crawler dễ dàng xác định và truy cập nội dung quan trọng.

- Ví dụ: Trang chủ > Danh mục sản phẩm > Trang chi tiết sản phẩm.

Tệp robots.txt chính xác

- Hướng dẫn crawler về các khu vực cần thu thập và những khu vực nên bỏ qua.

- Tránh cấu hình sai làm chặn các phần nội dung quan trọng hoặc toàn bộ website.

Sitemap XML đầy đủ

- Sitemap XML cung cấp danh sách toàn bộ URL mà crawler cần thu thập, giúp cải thiện khả năng tiếp cận các trang mới hoặc trang ít liên kết nội bộ.

- Ví dụ: Đối với một trang thương mại điện tử, sitemap nên bao gồm cả sản phẩm, danh mục và bài viết blog.

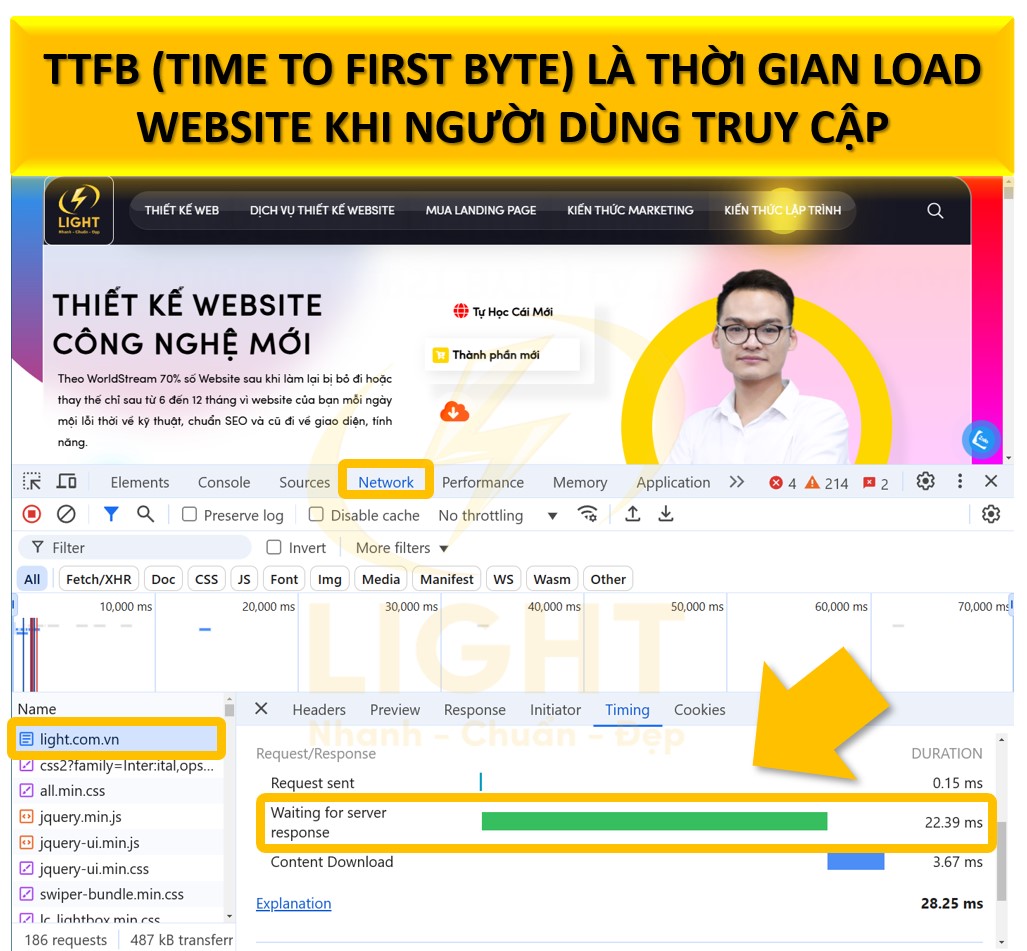

Tối ưu tốc độ tải trang

- Các trang tải chậm có thể khiến crawler từ bỏ quá trình quét hoặc chỉ thu thập một phần nội dung.

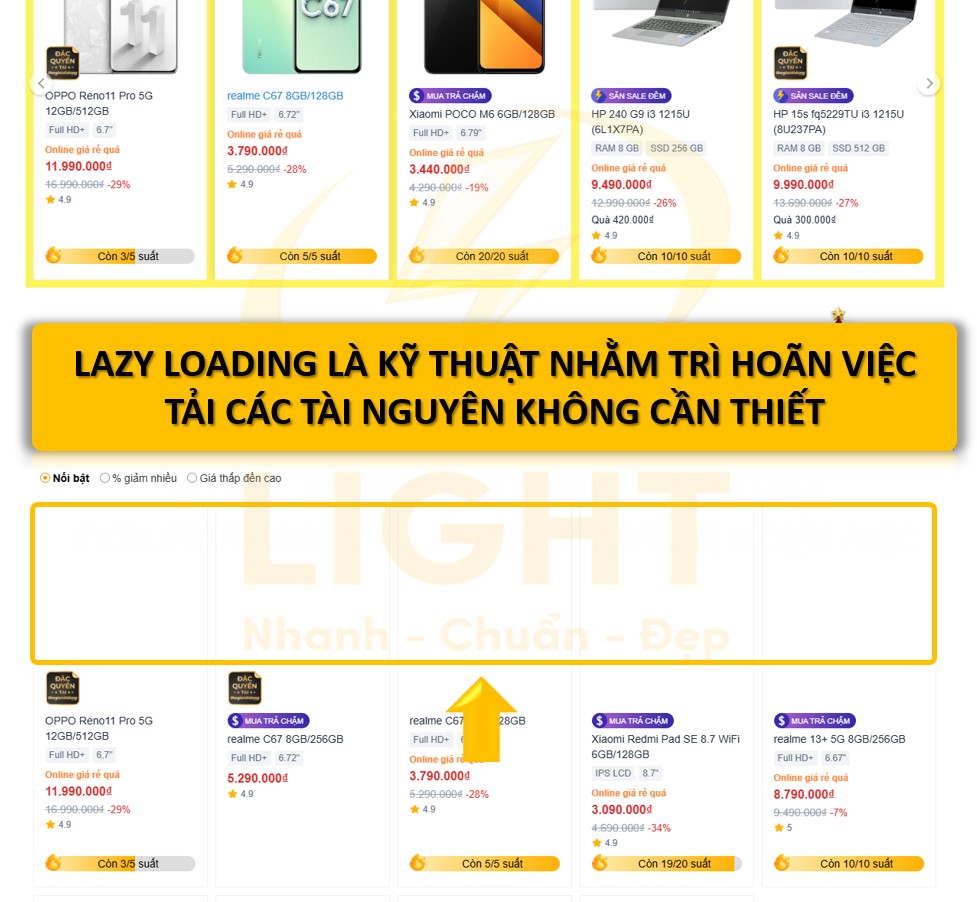

- Các yếu tố cần cải thiện gồm nén hình ảnh, sử dụng cache và giảm kích thước tệp JavaScript.

Xử lý nội dung động

- Nội dung được tải qua AJAX hoặc JavaScript phải được tối ưu để đảm bảo crawler có thể đọc và lập chỉ mục.

- Ví dụ: Sử dụng phiên bản HTML tĩnh hoặc các công cụ hỗ trợ như Google Dynamic Rendering.

Tác động của tối ưu hóa đối với hiệu quả thu thập dữ liệu

Tối ưu hóa không chỉ giúp crawler hoạt động hiệu quả hơn mà còn cải thiện thứ hạng website thông qua việc tăng tốc độ, cải thiện cấu trúc và loại bỏ các yếu tố gây cản trở.

Crawl Budget được sử dụng hiệu quả hơn

Crawl budget là lượng tài nguyên mà các công cụ tìm kiếm dành cho việc quét một website.

- Một website được tối ưu sẽ giảm số lần crawler lãng phí thời gian trên các trang lỗi, nội dung trùng lặp hoặc không quan trọng.

- Ví dụ: Sử dụng tệp robots.txt để loại bỏ các trang như giỏ hàng, trang đăng nhập khỏi quy trình quét.

Tăng tốc độ xử lý nội dung

Website tải nhanh giúp crawler thu thập được nhiều nội dung hơn trong khoảng thời gian giới hạn.

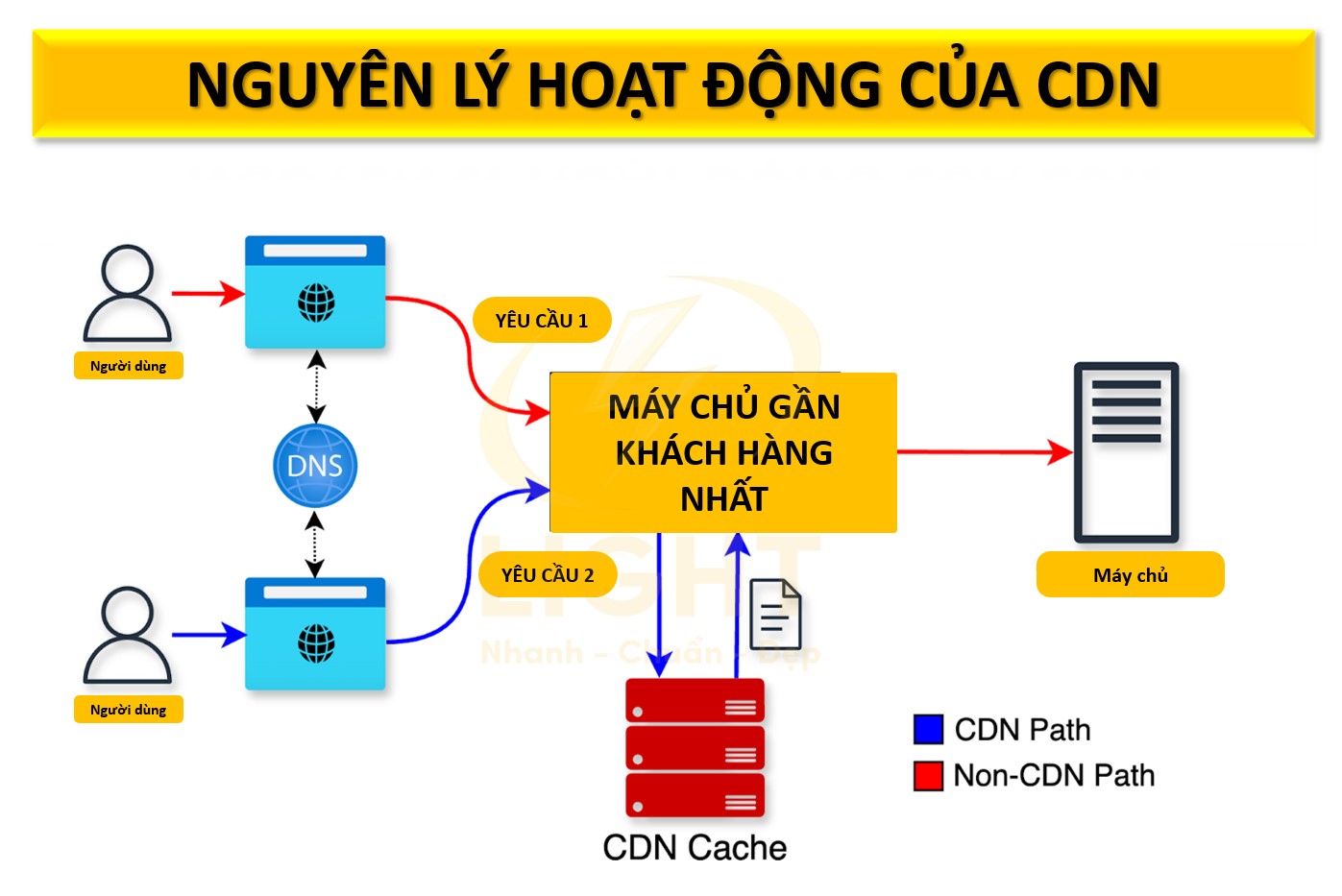

- Các kỹ thuật như sử dụng định dạng ảnh WebP, nén Gzip và CDN (Content Delivery Network) giúp cải thiện tốc độ tải trang đáng kể.

Đảm bảo khả năng tiếp cận toàn bộ nội dung

Crawler không thể quét được nội dung ẩn hoặc bị khóa bởi yêu cầu tương tác của người dùng.

- Cần kiểm tra và đảm bảo rằng nội dung quan trọng luôn hiển thị ngay cả khi không có sự tương tác từ người dùng.

- Ví dụ: Thay vì yêu cầu người dùng phải đăng nhập mới thấy nội dung, có thể cung cấp một phiên bản công khai cho crawler.

Loại bỏ lỗi kỹ thuật

Các lỗi như liên kết bị hỏng, mã trạng thái HTTP sai (404, 500), hoặc cấu hình tệp meta robots không chính xác có thể ngăn cản crawler truy cập nội dung.

- Sử dụng công cụ như Google Search Console để phát hiện và sửa lỗi liên kết hỏng hoặc các vấn đề lập chỉ mục.

Ưu tiên các nội dung giá trị cao

Cấu trúc liên kết nội bộ tốt giúp crawler dễ dàng xác định và lập chỉ mục các nội dung quan trọng, như sản phẩm mới, bài viết nổi bật hoặc các trang có tỷ lệ chuyển đổi cao.

Mối liên hệ giữa crawlability và SEO

Crawlability là yếu tố quyết định khả năng website được lập chỉ mục, trong khi SEO đảm bảo nội dung lập chỉ mục có chất lượng cao và xếp hạng tốt. Cả hai yếu tố này bổ trợ lẫn nhau và đều cần được tối ưu hóa đồng thời.

Cấu trúc URL chuẩn SEO

URL ngắn gọn, dễ đọc, chứa từ khóa liên quan giúp crawler hiểu nhanh nội dung của trang.

- Ví dụ: URL

/san-pham/ao-thun-namrõ ràng và dễ hiểu hơn URL/sp?id=1234.

Liên kết nội bộ mạnh mẽ

Một hệ thống liên kết nội bộ hợp lý giúp crawler truy cập dễ dàng vào các trang quan trọng và hỗ trợ truyền tải giá trị SEO (link juice).

- Các trang có liên kết nội bộ kém thường bị crawler bỏ qua, dẫn đến giảm khả năng lập chỉ mục.

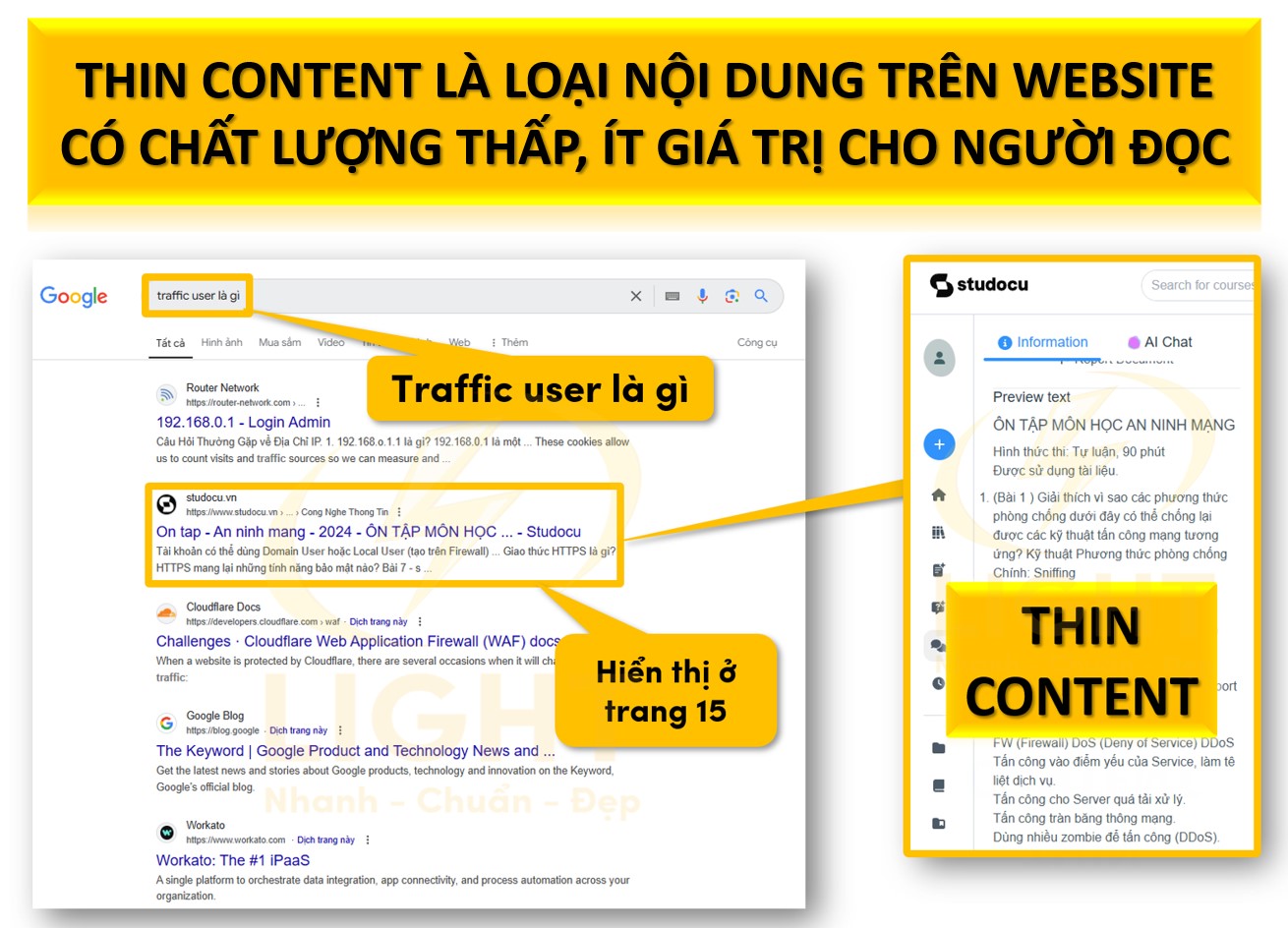

Tối ưu hóa nội dung chất lượng cao

Crawler ưu tiên lập chỉ mục các nội dung độc đáo và chất lượng. Nội dung trùng lặp hoặc mỏng (thin content) sẽ bị bỏ qua hoặc xếp hạng thấp.

- Ví dụ: Sử dụng thẻ canonical để chỉ định phiên bản chính của nội dung khi có nhiều URL hiển thị cùng một thông tin.

Tạo sitemap XML chuyên biệt

Sitemap XML giúp crawler nhanh chóng nhận biết các nội dung cần thu thập, đặc biệt trên các website lớn hoặc có cấu trúc phức tạp.

- Một website thương mại điện tử có thể tạo sitemap riêng cho sản phẩm, bài viết blog và danh mục.

Quản lý tệp robots.txt đúng cách

Robots.txt phải được cấu hình chính xác để hướng dẫn crawler truy cập các khu vực cần thiết và bỏ qua các phần không quan trọng, như trang admin hoặc tài liệu không liên quan.

- Ví dụ:

User-agent: *Disallow: /admin/Allow: /Sitemap: https://light.com/sitemap.xml

Tốc độ tải trang và trải nghiệm người dùng

Google ưu tiên các website có tốc độ tải nhanh và tối ưu cho thiết bị di động. Tối ưu hóa các yếu tố như mã nguồn, hình ảnh và font chữ giúp cải thiện cả crawlability và SEO.

- Ví dụ: Sử dụng AMP (Accelerated Mobile Pages) cho các bài viết tin tức để tăng tốc độ tải trên thiết bị di động.

Xử lý nội dung trùng lặp

Crawler thường bỏ qua các trang có nội dung trùng lặp, gây lãng phí tài nguyên và ảnh hưởng đến xếp hạng SEO.

- Sử dụng các công cụ như thẻ canonical hoặc redirect 301 để hợp nhất các phiên bản URL trùng lặp thành một URL duy nhất.

Cách tối ưu website để tăng hiệu suất thu thập thông tin

Một website tối ưu sẽ cung cấp môi trường thuận lợi cho các web crawler thông qua việc tổ chức cấu trúc URL thân thiện, xây dựng sitemap đầy đủ, và loại bỏ các rào cản kỹ thuật như lỗi crawl errors hay tốc độ tải trang chậm. Đồng thời, các yếu tố như liên kết nội bộ, liên kết bên ngoài, và nội dung chất lượng cao cũng đóng vai trò quan trọng trong việc hướng dẫn crawler đến các trang quan trọng và đảm bảo trải nghiệm người dùng tốt nhất.

Hướng dẫn này cung cấp những phương pháp tối ưu chi tiết để cải thiện khả năng thu thập dữ liệu, bao gồm cách kiểm tra lỗi crawl, tối ưu tốc độ tải trang, quản lý tệp robots.txt, xây dựng liên kết nội bộ hiệu quả, và xử lý các liên kết lỗi. Việc triển khai các biện pháp này không chỉ giúp tăng hiệu quả hoạt động của web crawler mà còn nâng cao chất lượng và giá trị tổng thể của website.

Cấu trúc website

Xây dựng cấu trúc URL thân thiện

URL đóng vai trò là cánh cổng đầu tiên để web crawler tiếp cận nội dung của website. Một cấu trúc URL thân thiện giúp tối ưu hóa hiệu quả thu thập thông tin:- URL cần ngắn gọn, mô tả chính xác nội dung trang. Ví dụ: thay vì sử dụng URL như

https://light.com/p=123, hãy dùng URL nhưhttps://light.com/huong-dan-seo. - Tránh sử dụng các ký tự đặc biệt hoặc tham số động phức tạp như

?id=123&ref=456. Thay vào đó, áp dụng cấu trúc URL tĩnh, sử dụng các từ khóa chính liên quan đến nội dung. - Sử dụng dấu gạch ngang (-) để phân tách từ thay vì dấu gạch dưới (_), vì các công cụ tìm kiếm coi dấu gạch ngang là khoảng trắng, trong khi dấu gạch dưới không được nhận dạng tương tự.

- Sử dụng chữ thường trong URL. Các URL phân biệt chữ hoa và chữ thường có thể gây ra lỗi nội dung trùng lặp, làm giảm hiệu quả thu thập thông tin.

- Hạn chế độ sâu của URL. Các trang quan trọng không nên bị chôn sâu quá ba cấp thư mục (ví dụ:

https://light.com/cap1/cap2/cap3), vì điều này làm giảm khả năng được crawler ưu tiên thu thập.

- URL cần ngắn gọn, mô tả chính xác nội dung trang. Ví dụ: thay vì sử dụng URL như

Tổ chức sitemap hiệu quả

Sitemap là tài liệu hướng dẫn cho crawler, giúp chúng hiểu được cấu trúc website và xác định các trang cần thu thập:- Tạo sitemap XML chứa danh sách tất cả các URL quan trọng trên website. Mỗi URL nên đi kèm với các thông tin như mức độ ưu tiên (priority), tần suất cập nhật (changefreq), và thời điểm cập nhật lần cuối (lastmod).

- Đảm bảo sitemap XML không vượt quá giới hạn 50.000 URL hoặc 50MB. Nếu website có quy mô lớn, hãy chia sitemap thành nhiều tệp nhỏ và liên kết chúng trong một file

sitemap index. - Sitemap HTML nên được cung cấp để hỗ trợ người dùng và crawler. Đây là một bản đồ liên kết dẫn đến các phần chính của website, giúp tối ưu hóa khả năng thu thập.

- Kiểm tra định kỳ sitemap bằng các công cụ như Google Search Console để đảm bảo không có lỗi 404 hoặc các trang bị chặn truy cập bởi robots.txt.

- Cập nhật sitemap ngay khi có sự thay đổi về cấu trúc hoặc nội dung của website để đảm bảo các công cụ tìm kiếm nhận diện nhanh nhất các thay đổi này.

Tối ưu nội dung

Đảm bảo nội dung chất lượng, có giá trị

Nội dung chất lượng là yếu tố quan trọng nhất để tối ưu hóa khả năng thu thập và xếp hạng:- Mỗi trang cần có nội dung độc đáo, chi tiết và trả lời trực tiếp các câu hỏi mà người dùng có thể tìm kiếm. Ví dụ: thay vì viết "Dịch vụ SEO tốt nhất", hãy cung cấp số liệu cụ thể, đánh giá hoặc lời chứng thực từ khách hàng.

- Loại bỏ hoặc hợp nhất các nội dung trùng lặp. Sử dụng thẻ chuẩn hóa (canonical tag) để thông báo cho công cụ tìm kiếm biết trang nào là bản chính, tránh xung đột trong lập chỉ mục.

- Tăng giá trị của nội dung bằng cách sử dụng hình ảnh, video, và đồ họa chất lượng cao. Đảm bảo các tài nguyên này được tối ưu hóa với tên tệp mô tả (image-name.jpg) và thẻ alt rõ ràng.

- Chia nội dung thành các đoạn văn ngắn với các điểm nổi bật rõ ràng. Sử dụng danh sách, bảng, hoặc các phần gạch đầu dòng để tăng tính dễ đọc và hấp dẫn cho cả người dùng và crawler.

- Sử dụng liên kết nội bộ (internal links) để kết nối các trang liên quan trong website. Điều này không chỉ tăng khả năng di chuyển của crawler mà còn cải thiện thời gian ở lại trang của người dùng.

Sử dụng heading (H1, H2, H3) hợp lý

Heading là yếu tố quan trọng để cấu trúc nội dung và hướng dẫn crawler nhận biết ý nghĩa của từng phần:- Mỗi trang chỉ nên có một thẻ H1 duy nhất, chứa từ khóa chính và mô tả chính xác nội dung trang. Ví dụ: H1 của trang hướng dẫn SEO có thể là "Cách tối ưu SEO hiệu quả năm 2025".

- Heading cấp H2 được sử dụng để chia nội dung thành các phần chính. Các tiêu đề này cần ngắn gọn, rõ ràng và chứa từ khóa liên quan. H3 được sử dụng để phân chia nội dung nhỏ hơn trong từng phần của H2.

- Không bỏ qua bất kỳ cấp độ heading nào. Đảm bảo thứ tự logic từ H1 đến H6 nếu nội dung yêu cầu. Việc bỏ qua các cấp độ có thể làm giảm khả năng hiểu cấu trúc của crawler.

- Không lạm dụng heading. Tránh việc sử dụng H1 hoặc H2 cho các đoạn văn bản không quan trọng, như tên menu hoặc mục lục phụ.

- Heading nên được đồng bộ hóa với nội dung bên dưới, đảm bảo rằng tất cả thông tin trong phần đó phản ánh đúng tiêu đề. Điều này giúp công cụ tìm kiếm lập chỉ mục chính xác và cung cấp kết quả phù hợp cho người dùng.

Tối ưu kỹ thuật

Kiểm tra và sửa lỗi crawl errors

Crawl errors là các vấn đề ngăn cản crawler truy cập và thu thập dữ liệu từ một hoặc nhiều trang trên website. Các loại lỗi phổ biến cần xử lý bao gồm:- 404 Not Found: URL không tồn tại do nội dung bị xóa hoặc sai địa chỉ.

- 500 Internal Server Error: Lỗi do máy chủ không thể xử lý yêu cầu.

- 403 Forbidden: Crawler không được phép truy cập một số khu vực.

- Redirect chain/loop: Chuỗi chuyển hướng quá dài hoặc vòng lặp chuyển hướng.

Cách khắc phục:

- Sử dụng công cụ phân tích:

- Google Search Console để xác định các lỗi thu thập dữ liệu.

- Screaming Frog để kiểm tra các lỗi liên kết nội bộ và bên ngoài.

- Sửa lỗi 404:

- Tạo redirect 301 từ URL cũ sang URL mới có nội dung tương tự.

- Cập nhật liên kết nội bộ và bên ngoài để tránh trỏ đến các trang không tồn tại.

- Khắc phục lỗi máy chủ (500):

- Kiểm tra nhật ký máy chủ (server logs) để xác định nguyên nhân.

- Tối ưu mã nguồn và cải thiện hiệu suất máy chủ.

- Giảm chuyển hướng (redirect chains):

- Giới hạn số lượng chuyển hướng trong một chuỗi (tối đa 1-2 lần).

- Sử dụng chuyển hướng trực tiếp từ URL ban đầu đến URL đích cuối cùng.

Tối ưu tốc độ tải trang

Tốc độ tải trang là yếu tố quan trọng giúp crawler quét nhanh hơn và tăng khả năng thu thập nhiều nội dung trong thời gian giới hạn. Theo nghiên cứu của Wang và cộng sự (2022) trong ‘Web Performance Optimization and Its Impact on Search Engine Crawlers’ (ACM Transactions on the Web), cải thiện tốc độ tải trang có tác động tích cực đến hiệu suất crawl của các công cụ tìm kiếm.Cách thực hiện:

- Nén tệp:

- Sử dụng Gzip để giảm kích thước HTML, CSS, và JavaScript.

- Kích hoạt HTTP/2 để cải thiện tốc độ truyền dữ liệu.

- Tối ưu hóa hình ảnh:

- Sử dụng định dạng WebP hoặc AVIF để giảm dung lượng mà không ảnh hưởng đến chất lượng.

- Cài đặt tính năng lazy loading để trì hoãn tải các hình ảnh ngoài màn hình.

- Giảm thiểu mã nguồn:

- Loại bỏ các đoạn mã CSS, JavaScript không sử dụng.

- Sử dụng các công cụ như UglifyJS hoặc CSSNano để rút gọn mã.

- Tối ưu cơ sở dữ liệu:

- Loại bỏ các bản ghi không cần thiết.

- Sử dụng bộ nhớ đệm cơ sở dữ liệu để tăng tốc truy vấn.

- Sử dụng CDN (Content Delivery Network):

- Phân phối nội dung qua nhiều máy chủ trên toàn cầu để giảm độ trễ và cải thiện hiệu suất.

Sử dụng tệp robots.txt hợp lý

Robots.txt là tệp quan trọng hướng dẫn crawler về các khu vực trên website được phép hoặc không được phép thu thập dữ liệu. Nếu bạn chưa biết tệp robots.txt là gì, hãy tìm hiểu ngay để tránh vô tình chặn các trang quan trọng.Cách cấu hình:

- Cho phép truy cập vào nội dung quan trọng:

- Đảm bảo các trang như danh mục sản phẩm, bài viết blog hoặc trang giới thiệu công ty luôn mở cho crawler.

- Chặn các khu vực không cần thiết:

- Loại bỏ các thư mục như

/admin/,/wp-includes/, hoặc các trang chứa thông tin nhạy cảm.

- Loại bỏ các thư mục như

- Kiểm tra tệp robots.txt định kỳ:

- Sử dụng công cụ Google Search Console để kiểm tra tính chính xác của tệp.

- Cung cấp liên kết đến sitemap XML:

- Ví dụ tệp robots.txt tối ưu:

Liên kết nội bộ và bên ngoài

Tạo liên kết nội bộ rõ ràng, trực quan

Liên kết nội bộ đóng vai trò định hướng cho crawler khám phá toàn bộ nội dung website, đồng thời hỗ trợ truyền tải giá trị SEO giữa các trang. Khi xây dựng website, việc nắm bắt internal link là gì giúp bạn thiết lập hệ thống điều hướng tối ưu.Cách thực hiện:

- Xây dựng cấu trúc liên kết logic:

- Từ trang chủ dẫn đến danh mục chính, từ danh mục chính dẫn đến các trang chi tiết.

- Đảm bảo rằng các trang quan trọng như sản phẩm bán chạy, bài viết nổi bật luôn có liên kết từ các trang khác.

- Sử dụng anchor text mô tả chính xác:

- Anchor text nên chứa từ khóa liên quan và mô tả nội dung trang đích.

- Ví dụ: Thay vì "Xem thêm", sử dụng "Xem chi tiết áo thun nam".

- Kiểm tra độ sâu của liên kết:

- Các trang quan trọng không nên nằm quá sâu trong cấu trúc liên kết (tối đa 3 lần nhấp từ trang chủ).

Tránh liên kết đến trang lỗi hoặc nội dung bị xóa

Liên kết hỏng làm lãng phí crawl budget và ảnh hưởng tiêu cực đến trải nghiệm người dùng.Cách thực hiện:

- Kiểm tra định kỳ liên kết bị lỗi:

- Sử dụng công cụ như Ahrefs hoặc Screaming Frog để phát hiện và sửa các liên kết dẫn đến trang 404.

- Cập nhật liên kết khi nội dung thay đổi:

- Khi xóa hoặc di chuyển nội dung, đảm bảo liên kết nội bộ và bên ngoài được cập nhật tương ứng.

- Sử dụng redirect 301:

- Khi một URL thay đổi, sử dụng chuyển hướng 301 để duy trì giá trị SEO và dẫn crawler đến nội dung mới.

Tối ưu hóa liên kết bên ngoài (external links)

Liên kết đến các website khác cũng cần được quản lý chặt chẽ để không gây ảnh hưởng tiêu cực đến website. Khi liên kết đến các trang khác, hãy nắm vững external link là gì để đảm bảo không làm giảm giá trị SEO.Cách thực hiện:

- Liên kết đến nguồn uy tín:

- Chỉ trỏ đến các trang có nội dung đáng tin cậy và an toàn.

- Thêm thẻ rel="nofollow" khi cần thiết:

- Áp dụng cho các liên kết quảng cáo hoặc liên kết không muốn truyền giá trị SEO.

- Kiểm tra trạng thái liên kết định kỳ:

- Đảm bảo liên kết bên ngoài vẫn hoạt động và không chuyển hướng đến nội dung không mong muốn.

Các biện pháp tối ưu trên đảm bảo rằng crawler dễ dàng truy cập, thu thập dữ liệu đầy đủ, và lập chỉ mục các nội dung quan trọng, giúp website đạt hiệu suất tốt nhất trên công cụ tìm kiếm.

4 Công cụ hỗ trợ tối ưu hóa website cho web crawler

Những công cụ SEO này giúp quản trị viên phát hiện các lỗi kỹ thuật như liên kết bị hỏng, tốc độ tải trang chậm, hoặc vấn đề liên quan đến thẻ meta. Đồng thời, chúng cung cấp thông tin chi tiết về cấu trúc liên kết nội bộ, khả năng crawlability, và hiệu suất tổng thể của website. Các công cụ như Google Search Console, Screaming Frog, Ahrefs, và SEMrush không chỉ cung cấp dữ liệu quan trọng mà còn hỗ trợ triển khai các biện pháp khắc phục, tối ưu hóa toàn diện từ kỹ thuật đến nội dung.

Hướng dẫn dưới đây sẽ đi sâu vào vai trò và cách sử dụng từng công cụ, giúp bạn cải thiện khả năng thu thập dữ liệu của web crawler, từ đó nâng cao thứ hạng và hiệu quả hoạt động của website.

1. Google Search Console

Google Search Console là một công cụ miễn phí do Google cung cấp, giúp quản trị viên theo dõi và cải thiện hiệu suất của website trên kết quả tìm kiếm.

Chức năng chính

Phát hiện lỗi crawl, bao gồm lỗi 404 (Not Found), 500 (Internal Server Error) và các URL bị chặn bởi robots.txt hoặc meta robots. Báo cáo chi tiết giúp quản trị viên xác định các vấn đề cụ thể và ưu tiên sửa chữa.

Theo dõi trạng thái lập chỉ mục (Index Coverage), cung cấp thông tin về các trang được lập chỉ mục, các trang bị loại trừ hoặc không thể lập chỉ mục do lỗi.

Gửi sitemap XML để hướng dẫn Googlebot thu thập dữ liệu hiệu quả hơn. Công cụ cho phép kiểm tra tính hợp lệ của sitemap và hiển thị thông báo nếu có vấn đề.

Kiểm tra hiệu suất (Performance) của từng URL, bao gồm từ khóa xếp hạng, số lần hiển thị, tỷ lệ nhấp chuột (CTR), và vị trí trung bình trên kết quả tìm kiếm.

Kiểm tra khả năng tương thích với thiết bị di động (Mobile Usability) để phát hiện và sửa lỗi ảnh hưởng đến trải nghiệm người dùng và khả năng thu thập dữ liệu.

Cách sử dụng

Xác minh quyền sở hữu website thông qua DNS, HTML file, hoặc thẻ meta.

Gửi sitemap XML để đảm bảo Googlebot nhận diện đầy đủ cấu trúc website. Để đảm bảo website được lập chỉ mục đầy đủ, bạn cần hiểu Google Search Console là gì và cách gửi sitemap XML.

Kiểm tra báo cáo "Crawl Stats" để theo dõi số lượng yêu cầu và thời gian tải trung bình mà Googlebot dành cho website.

Thực hiện sửa lỗi dựa trên các vấn đề được báo cáo trong phần "Index Coverage" hoặc "Enhancements".

2. Screaming Frog

Screaming Frog là công cụ chuyên dụng mô phỏng hoạt động của web crawler, cho phép phân tích toàn bộ cấu trúc website để phát hiện các vấn đề kỹ thuật.

Chức năng chính

Phân tích cấu trúc liên kết nội bộ và bên ngoài, giúp xác định các trang không được liên kết hiệu quả, liên kết hỏng, hoặc vòng lặp chuyển hướng.

Kiểm tra và phân tích thẻ meta, bao gồm tiêu đề (title tag), meta description, và heading. Công cụ giúp phát hiện nội dung trùng lặp, thiếu hoặc không tối ưu.

Đánh giá tốc độ tải trang bằng cách tích hợp với Google PageSpeed Insights, cung cấp các yếu tố kỹ thuật ảnh hưởng đến hiệu suất.

Kiểm tra robots.txt và meta robots để xác định các trang bị chặn không hợp lý hoặc được cấu hình sai.

Tạo sitemap XML với các URL ưu tiên, tần suất cập nhật, và ngày cập nhật gần nhất. Công cụ hỗ trợ phân đoạn sitemap cho các website lớn.

Cách sử dụng

Cài đặt và nhập URL website vào Screaming Frog để bắt đầu quét.

Phân tích báo cáo lỗi và danh sách các trang có vấn đề, như liên kết bị lỗi hoặc nội dung thiếu thẻ meta.

Sử dụng tính năng "Visualisation" để xem sơ đồ liên kết nội bộ và xác định các trang bị bỏ sót hoặc không hiệu quả.

Xuất báo cáo và thực hiện các chỉnh sửa trực tiếp trên website dựa trên các lỗi được phát hiện.

3. Ahrefs và SEMrush

Ahrefs và SEMrush là hai công cụ SEO toàn diện, cung cấp cả chức năng kiểm tra kỹ thuật và phân tích nội dung, liên kết.

Chức năng chính của Ahrefs

Kiểm tra sức khỏe website (Site Audit), phát hiện các lỗi như liên kết hỏng, nội dung trùng lặp, lỗi HTTP, hoặc tốc độ tải trang chậm. Báo cáo đi kèm hướng dẫn chi tiết để sửa lỗi.

Phân tích backlink, giúp theo dõi chất lượng và số lượng liên kết trỏ về website. Công cụ cũng phát hiện các backlink độc hại để loại bỏ hoặc từ chối (disavow).

Nghiên cứu từ khóa, cung cấp danh sách từ khóa liên quan và thông tin về mức độ cạnh tranh, lượng tìm kiếm, và tiềm năng xếp hạng.

Theo dõi vị trí xếp hạng (Rank Tracker), giúp kiểm tra hiệu suất từ khóa và các trang cụ thể trên kết quả tìm kiếm.

Chức năng chính của SEMrush

Phân tích kỹ thuật website (Site Audit), kiểm tra các lỗi crawl, nội dung trùng lặp, tốc độ tải trang, và chỉ dẫn meta robots. Công cụ cung cấp ưu tiên sửa lỗi để tối ưu hiệu suất.

Phân tích liên kết nội bộ và bên ngoài, hiển thị cách các trang được kết nối và xác định các liên kết bị lỗi hoặc không tối ưu.

Công cụ nghiên cứu từ khóa mạnh mẽ, cung cấp các từ khóa mới, từ khóa xu hướng, và cơ hội tăng thứ hạng cho từng nội dung.

Hỗ trợ Local SEO, tối ưu hóa các yếu tố địa phương như Google My Business để tăng khả năng hiển thị trong các tìm kiếm địa phương.

Cách sử dụng

Đăng ký tài khoản Ahrefs hoặc SEMrush và thêm website vào công cụ để theo dõi.

Sử dụng tính năng "Site Audit" để kiểm tra toàn bộ website và lập danh sách các vấn đề cần xử lý.

Theo dõi backlink và thực hiện disavow nếu phát hiện các liên kết không tự nhiên hoặc từ nguồn không uy tín.

Sử dụng các báo cáo từ nghiên cứu từ khóa để tối ưu nội dung, cải thiện khả năng thu thập và xếp hạng.

Các lỗi phổ biến cản trở web crawler

Web crawler đóng vai trò quan trọng trong việc thu thập và lập chỉ mục nội dung website. Tuy nhiên, các lỗi kỹ thuật phổ biến có thể làm gián đoạn quá trình này, ảnh hưởng đến khả năng hiển thị và hiệu quả SEO. Dưới đây là phân tích chuyên sâu về các lỗi thường gặp và cách xử lý chi tiết.

Nội dung trùng lặp

Nguyên nhân gây ra nội dung trùng lặp:

- URL khác nhau dẫn đến cùng một nội dung: Khi một trang web có nhiều phiên bản URL như HTTP và HTTPS, có hoặc không có "www", hoặc các URL chứa tham số động (

?id=123,?ref=abc), các crawler có thể coi đây là các trang riêng biệt, dù nội dung thực chất giống nhau. Nếu website có nhiều phiên bản URL giống nhau, hãy xem xét duplicate content là gì để tránh lỗi trùng lặp. - Sao chép nội dung từ các nguồn khác: Việc sử dụng lại nội dung từ các trang web khác mà không thay đổi đáng kể hoặc không ghi rõ nguồn gốc có thể gây ra xung đột trong việc xác định quyền sở hữu nội dung.

- Phân trang nội dung: Các bài viết được chia thành nhiều trang hoặc phiên bản in riêng biệt có thể tạo ra nội dung trùng lặp nếu không được xử lý cẩn thận.

Hậu quả của nội dung trùng lặp:

- Làm giảm khả năng các công cụ tìm kiếm xác định chính xác trang nào cần được ưu tiên lập chỉ mục.

- Phân tán giá trị xếp hạng giữa các trang, làm giảm hiệu quả SEO.

- Gây ra cảnh báo từ các công cụ quản trị website, như Google Search Console, về vấn đề nội dung trùng lặp.

Phương pháp khắc phục:

- Sử dụng thẻ canonical: Xác định URL chính thức cho từng nội dung bằng thẻ canonical. Điều này giúp web crawler hiểu rằng tất cả các phiên bản URL khác đều chỉ là bản sao.

- Chuyển hướng 301: Cấu hình server để tự động chuyển hướng tất cả các phiên bản URL không mong muốn về URL chuẩn.

- Loại bỏ hoặc hợp nhất nội dung trùng lặp: Xóa các trang trùng lặp hoặc hợp nhất chúng thành một nội dung duy nhất. Nếu cần giữ lại phiên bản phụ, sử dụng thẻ meta

noindexđể loại trừ khỏi kết quả tìm kiếm.

Cấu trúc URL phức tạp

Một trong những yếu tố quan trọng trong SEO là biết URL là gì và cách tối ưu hóa chúng cho website

Đặc điểm của cấu trúc URL không tối ưu:

- URL chứa tham số động khó hiểu: Ví dụ,

https://light.com/product?id=123&ref=456&session=789không cung cấp thông tin rõ ràng về nội dung trang, gây khó khăn cho cả người dùng và crawler. - URL không mô tả nội dung: Các URL tự động tạo ra từ hệ thống quản lý nội dung (CMS) thường chứa các ký tự không liên quan đến nội dung.

- Độ sâu thư mục quá lớn: URL có quá nhiều cấp thư mục, ví dụ

https://light.com/category/subcategory/subsubcategory/page, làm giảm khả năng crawler tiếp cận các trang sâu.

Hậu quả của cấu trúc URL phức tạp:

- Gây lãng phí crawl budget khi crawler phải xử lý nhiều URL không cần thiết hoặc không có giá trị.

- Các trang quan trọng bị bỏ qua vì không nằm trong phạm vi ưu tiên của web crawler.

- Tăng nguy cơ nhầm lẫn nội dung hoặc trùng lặp do các tham số URL khác nhau.

Phương pháp khắc phục:

- Tạo URL tĩnh và rõ ràng: URL nên ngắn gọn, dễ đọc và bao gồm từ khóa liên quan đến nội dung. Ví dụ,

https://light.com/huong-dan-seothay vìhttps://light.com?id=123.

- Sử dụng kỹ thuật URL rewrite: Cấu hình file

.htaccesshoặc server để chuyển đổi URL động thành URL tĩnh mà không làm mất dữ liệu. - Giảm độ sâu thư mục: Đảm bảo các trang quan trọng nằm trong phạm vi ba cấp thư mục đầu tiên để cải thiện khả năng truy cập.

Lỗi redirect không chính xác

Các loại lỗi redirect thường gặp:

- Chuỗi redirect: Một URL chuyển hướng qua nhiều bước trước khi đến URL đích. Ví dụ,

URL A → URL B → URL C. Mỗi bước làm mất thời gian và tài nguyên của crawler. Nếu website của bạn có nhiều chuỗi chuyển hướng, hãy xem xét lại redirect 301 là gì để tối ưu hóa. - Vòng lặp redirect: URL chuyển hướng quay trở lại chính nó hoặc tạo thành một vòng lặp vô hạn, khiến crawler không thể thoát ra.

- Sử dụng redirect tạm thời (302): Redirect 302 báo hiệu cho crawler rằng chuyển hướng này chỉ tạm thời, dẫn đến việc các công cụ tìm kiếm không chuyển giá trị SEO từ URL cũ sang URL mới.

Hậu quả của lỗi redirect không chính xác:

- Gây lãng phí crawl budget khi crawler phải theo dõi quá nhiều bước chuyển hướng hoặc bị mắc kẹt trong vòng lặp.

- Làm giảm hiệu quả SEO khi các URL chuyển hướng không đúng loại hoặc không được tối ưu hóa.

- Gây trải nghiệm kém cho người dùng khi truy cập qua nhiều bước chuyển hướng hoặc gặp lỗi.

Phương pháp khắc phục:

- Sử dụng redirect vĩnh viễn (301): Chuyển hướng các URL lỗi thời hoặc không còn sử dụng về URL mới bằng mã trạng thái HTTP 301. Redirect này cũng giúp chuyển toàn bộ giá trị SEO từ URL cũ.

- Hạn chế chuỗi redirect: Kiểm tra các cấu trúc redirect hiện có và tối giản hóa. Mỗi URL chỉ nên có một bước chuyển hướng đến URL đích.

- Kiểm tra định kỳ lỗi redirect: Sử dụng các công cụ như Screaming Frog, Ahrefs hoặc Google Search Console để phát hiện và xử lý các vấn đề redirect sớm.

Những lỗi này không chỉ làm giảm hiệu quả thu thập thông tin của web crawler mà còn ảnh hưởng nghiêm trọng đến xếp hạng website trên các công cụ tìm kiếm. Loại bỏ và khắc phục chúng là điều kiện tiên quyết để đảm bảo website vận hành hiệu quả.

Khóa học SEO có giúp tối ưu website để web crawler dễ thu thập thông tin không?

Khóa học SEO là một giải pháp hữu ích để giúp người học hiểu cách tối ưu hóa website cho web crawler, từ đó cải thiện khả năng thu thập thông tin và lập chỉ mục nội dung. Một khóa học SEO chất lượng không chỉ tập trung vào việc nâng cao thứ hạng website mà còn cung cấp các kiến thức chuyên sâu về cách thiết lập cấu trúc và tối ưu hóa kỹ thuật nhằm hỗ trợ hiệu quả quá trình thu thập dữ liệu của web crawler.

1. Cấu trúc website tối ưu cho web crawler

Các khóa học SEO thường dạy cách xây dựng một cấu trúc website hợp lý, giúp crawler dễ dàng truy cập và thu thập dữ liệu. Những kiến thức này bao gồm:

Tổ chức cấu trúc liên kết nội bộ:

- Cách xây dựng các liên kết giữa các trang quan trọng như danh mục sản phẩm, bài viết blog và trang chủ.

- Sử dụng anchor text rõ ràng và chứa từ khóa liên quan để giúp crawler hiểu nội dung của trang đích.

Tối ưu hóa URL thân thiện với SEO:

Theo nghiên cứu của Zhang và cộng sự (2021), URL có cấu trúc tối ưu, ngắn gọn và sử dụng từ khóa chính có thể cải thiện hiệu quả SEO.- Hướng dẫn tạo các URL ngắn gọn, sử dụng từ khóa liên quan và loại bỏ các ký tự đặc biệt.

- Tránh các URL động phức tạp và sử dụng URL tĩnh để tăng khả năng thu thập dữ liệu.

2. Tối ưu kỹ thuật SEO (Technical SEO)

Một phần quan trọng của khóa học SEO là tập trung vào các yếu tố kỹ thuật, giúp website sẵn sàng cho việc thu thập dữ liệu. Khi tối ưu website, nắm vững Technical SEO là gì sẽ giúp bạn khắc phục các lỗi ảnh hưởng đến thứ hạng tìm kiếm. Các nội dung thường được giảng dạy gồm:

Quản lý tệp robots.txt:

- Cách cấu hình robots.txt để chỉ định các khu vực trên website mà crawler có thể hoặc không thể truy cập.

- Kiểm tra và khắc phục các lỗi cấu hình khiến các trang quan trọng bị chặn.

Tối ưu hóa sitemap XML:

- Tạo sitemap XML chi tiết để hướng dẫn crawler thu thập các trang quan trọng.

- Kiểm tra tính hợp lệ của sitemap bằng công cụ như Google Search Console.

Xử lý lỗi crawl (Crawl Errors):

- Hướng dẫn sử dụng các công cụ như Screaming Frog hoặc Ahrefs để phát hiện các lỗi 404, 500, hoặc vòng lặp chuyển hướng.

- Khắc phục lỗi bằng cách thiết lập chuyển hướng 301 hoặc sửa các liên kết bị lỗi.

Tăng tốc độ tải trang:

- Giảm thời gian tải trang bằng cách nén hình ảnh, tối ưu mã nguồn, và sử dụng mạng phân phối nội dung (CDN).

- Cải thiện tốc độ giúp crawler thu thập nhiều dữ liệu hơn trong giới hạn crawl budget.

3. Tối ưu nội dung hỗ trợ thu thập dữ liệu

Khóa học SEO cũng tập trung vào việc tạo ra nội dung chất lượng cao, phù hợp với các tiêu chí của web crawler. Những kỹ năng này bao gồm:

Tạo nội dung duy nhất và có giá trị:

- Loại bỏ nội dung trùng lặp và sử dụng thẻ canonical để xác định trang gốc.

- Cung cấp thông tin hữu ích, trả lời trực tiếp các truy vấn của người dùng.

Sử dụng thẻ meta và heading hợp lý:

- Hướng dẫn tối ưu hóa thẻ tiêu đề (title tag), meta description và heading (H1, H2, H3).

- Cách sắp xếp nội dung theo cấu trúc logic để crawler dễ dàng phân tích.

4. Hướng dẫn sử dụng công cụ hỗ trợ

Một khóa học SEO chất lượng sẽ giới thiệu và hướng dẫn cách sử dụng các công cụ hỗ trợ tối ưu hóa website cho web crawler, bao gồm:

- Google Search Console: Phân tích lỗi crawl, gửi sitemap, kiểm tra chỉ số lập chỉ mục.

- Screaming Frog: Quét website để phát hiện các vấn đề liên quan đến cấu trúc liên kết và kỹ thuật SEO.

- Ahrefs và SEMrush: Phân tích backlink, theo dõi từ khóa, và kiểm tra sức khỏe website.

5. Kết hợp chiến lược SEO và hỗ trợ web crawler

Khóa học SEO không chỉ giúp tối ưu hóa cho web crawler mà còn hướng dẫn cách kết hợp chiến lược SEO tổng thể để tăng hiệu quả. Những kỹ năng này bao gồm:

Tăng khả năng hiển thị của nội dung mới:

- Hướng dẫn cách ưu tiên các bài viết hoặc sản phẩm mới bằng cách tạo liên kết nội bộ và cập nhật sitemap.

Quản lý crawl budget hiệu quả:

- Chặn các trang không cần thiết như trang đăng nhập hoặc trang không mang lại giá trị.

- Tăng cường crawlability cho các trang quan trọng bằng cách cải thiện tốc độ và giảm lỗi kỹ thuật.

Làm sao để thiết kế website chuẩn SEO tối ưu hóa tốt nhất cho web crawler?

Thiết kế website chuẩn SEO không chỉ giúp nâng cao trải nghiệm người dùng mà còn tối ưu hóa khả năng thu thập và lập chỉ mục dữ liệu của web crawler. Điều này đảm bảo rằng nội dung trên website được công cụ tìm kiếm nhận diện, hiểu đúng ngữ cảnh và hiển thị ở vị trí tốt nhất trên kết quả tìm kiếm. Khi tối ưu website, bạn cần biết thiết kế web chuẩn SEO là gì để đảm bảo khả năng lập chỉ mục tốt nhất. Dưới đây là các phương pháp chi tiết, chuyên môn cao để thiết kế website chuẩn SEO và thân thiện với web crawler.

1. Cấu trúc website rõ ràng và logic

- Tổ chức nội dung phân cấp: Xây dựng cấu trúc nội dung theo dạng cây, với các danh mục chính (categories) và danh mục con (subcategories) được liên kết logic. Điều này giúp crawler dễ dàng điều hướng và lập chỉ mục toàn bộ nội dung.

- Liên kết nội bộ hiệu quả: Tạo liên kết nội bộ giữa các trang có liên quan để tăng khả năng crawler khám phá nội dung. Mỗi trang nên có ít nhất một liên kết từ trang khác dẫn tới.

- Đảm bảo độ sâu hợp lý: Các trang quan trọng không nên nằm sâu quá ba cấp thư mục từ trang chủ, vì các cấp độ quá sâu có thể bị crawler bỏ qua.

2. Xây dựng URL thân thiện với SEO

- Ngắn gọn và dễ hiểu: URL cần ngắn, chứa từ khóa liên quan đến nội dung và không có ký tự đặc biệt hoặc tham số động không cần thiết.

- Sử dụng dấu gạch ngang (-): Dấu gạch ngang giúp phân tách từ khóa và cải thiện khả năng đọc của URL.

- Thống nhất cấu trúc: Duy trì cấu trúc URL nhất quán trên toàn bộ website để tránh gây nhầm lẫn cho crawler.

3. Tối ưu nội dung cho công cụ tìm kiếm

- Cung cấp nội dung chất lượng: Nội dung cần độc đáo, chuyên sâu và giải đáp trực tiếp các câu hỏi của người dùng. Sử dụng từ khóa chính và từ khóa liên quan một cách tự nhiên trong toàn bộ nội dung.

- Định dạng dễ đọc: Sử dụng đoạn văn ngắn, tiêu đề phụ (H2, H3), danh sách, bảng biểu và hình ảnh minh họa để tăng tính hấp dẫn cho cả người dùng và crawler.

- Cập nhật nội dung định kỳ: Các công cụ tìm kiếm ưu tiên lập chỉ mục các nội dung mới hoặc thường xuyên được cập nhật.

4. Tối ưu thẻ HTML

Khi tạo nội dung website, bạn cần biết HTML là gì để định dạng văn bản và cải thiện trải nghiệm người dùng.

- Thẻ tiêu đề (title): Mỗi trang cần có một thẻ tiêu đề duy nhất, chứa từ khóa chính và mô tả rõ ràng nội dung của trang.

- Thẻ mô tả (meta description): Thẻ này cần tóm tắt ngắn gọn nội dung của trang, sử dụng từ khóa chính và có độ dài tối ưu từ 150–160 ký tự.

- Thẻ heading: Sử dụng các thẻ H1, H2, H3 theo cấu trúc phân cấp. H1 dành cho tiêu đề chính, H2 cho các tiêu đề phụ, và H3 cho nội dung chi tiết hơn.

- Thẻ alt cho hình ảnh: Đảm bảo mỗi hình ảnh có thẻ alt mô tả nội dung, giúp công cụ tìm kiếm hiểu được hình ảnh.

5. Tạo và duy trì sitemap XML

Nếu bạn chưa biết sitemap là gì, hãy tìm hiểu ngay để giúp công cụ tìm kiếm thu thập dữ liệu website hiệu quả hơn.

- Cập nhật định kỳ: Sitemap XML cần được cập nhật mỗi khi có thay đổi trên website để đảm bảo crawler nhận diện nội dung mới.

- Chỉ định ưu tiên: Xác định mức độ ưu tiên và tần suất cập nhật của từng trang trong sitemap.

- Đăng ký với công cụ tìm kiếm: Gửi sitemap XML đến Google Search Console và các công cụ tìm kiếm khác để đảm bảo nội dung được lập chỉ mục.

6. Tối ưu hóa tốc độ tải trang

- Sử dụng CDN: Hệ thống phân phối nội dung (Content Delivery Network) giúp giảm độ trễ và tăng tốc độ tải trang trên toàn cầu.

- Tối ưu hóa hình ảnh: Nén hình ảnh và sử dụng định dạng phù hợp như WebP để giảm kích thước tệp mà không ảnh hưởng đến chất lượng.

- Hạn chế mã không cần thiết: Loại bỏ mã JavaScript và CSS không sử dụng để tăng tốc độ tải trang.

- Bật nén Gzip: Kích hoạt nén Gzip trên server để giảm dung lượng dữ liệu truyền tải.

7. Đảm bảo website thân thiện với thiết bị di động

- Thiết kế responsive: Website cần tự động điều chỉnh giao diện để phù hợp với mọi kích thước màn hình, từ máy tính bàn đến điện thoại di động.

- Kiểm tra hiệu suất trên thiết bị di động: Sử dụng công cụ Google Mobile-Friendly Test để đảm bảo trang web hoạt động tốt trên các thiết bị di động.

8. Tuân thủ quy định robots.txt

- Cho phép các phần quan trọng: Cấu hình file robots.txt để đảm bảo các phần quan trọng của website, như nội dung chính và sitemap, được phép thu thập thông tin.

- Hạn chế phần không cần thiết: Ngăn crawler truy cập vào các trang không quan trọng, như trang quản trị hoặc dữ liệu riêng tư.

9. Sử dụng dữ liệu có cấu trúc (Schema Markup)

Nếu bạn muốn tăng khả năng xuất hiện trong rich results, hãy nghiên cứu Schema Markup là gì và cách triển khai chính xác.

- Áp dụng schema phù hợp: Sử dụng dữ liệu có cấu trúc để mô tả các loại nội dung cụ thể như bài viết, sản phẩm, đánh giá, hoặc sự kiện. Điều này giúp công cụ tìm kiếm hiểu rõ hơn về nội dung của website.

- Kiểm tra dữ liệu có cấu trúc: Sử dụng công cụ Rich Results Test của Google để kiểm tra tính chính xác và hiệu quả của dữ liệu có cấu trúc.

10. Giám sát và cải thiện liên tục

- Theo dõi hiệu suất: Sử dụng các công cụ như Google Analytics và Google Search Console để giám sát lưu lượng truy cập, các trang được lập chỉ mục và lỗi thu thập thông tin.

- Khắc phục lỗi sớm: Xử lý các vấn đề như lỗi 404, lỗi redirect hoặc nội dung trùng lặp ngay khi phát hiện để tránh ảnh hưởng đến quá trình crawling.

- Kiểm tra định kỳ: Chạy các công cụ kiểm tra như Screaming Frog hoặc Ahrefs để đảm bảo website không có lỗi kỹ thuật cản trở crawler.

Bằng cách áp dụng những phương pháp trên, website sẽ được thiết kế tối ưu không chỉ cho web crawler mà còn nâng cao trải nghiệm người dùng, từ đó cải thiện hiệu quả SEO tổng thể.

Chi tiết: https://light.com.vn/minh-hm

Youtube: https://www.youtube.com/@minhhmchanel2340