Googlebot là gì? Các kiến thức quan trọng về Googlebot

Hiểu cách Googlebot thu thập và lập chỉ mục dữ liệu là chìa khóa giúp website đạt thứ hạng cao trên Google. Công cụ như Google Search Console, Screaming Frog, Ahrefs và SEMrush hỗ trợ quản trị viên theo dõi tần suất thu thập dữ liệu, phát hiện lỗi và tối ưu trang theo tiêu chuẩn của Google.

Bên cạnh đó, phân tích nhật ký máy chủ giúp xác minh Googlebot có truy cập đúng nội dung quan trọng hay không, từ đó điều chỉnh chiến lược SEO phù hợp. Kết hợp các công cụ và phương pháp kiểm tra chuyên sâu sẽ giúp website được thu thập và lập chỉ mục hiệu quả, tối đa hóa khả năng hiển thị trên công cụ tìm kiếm.

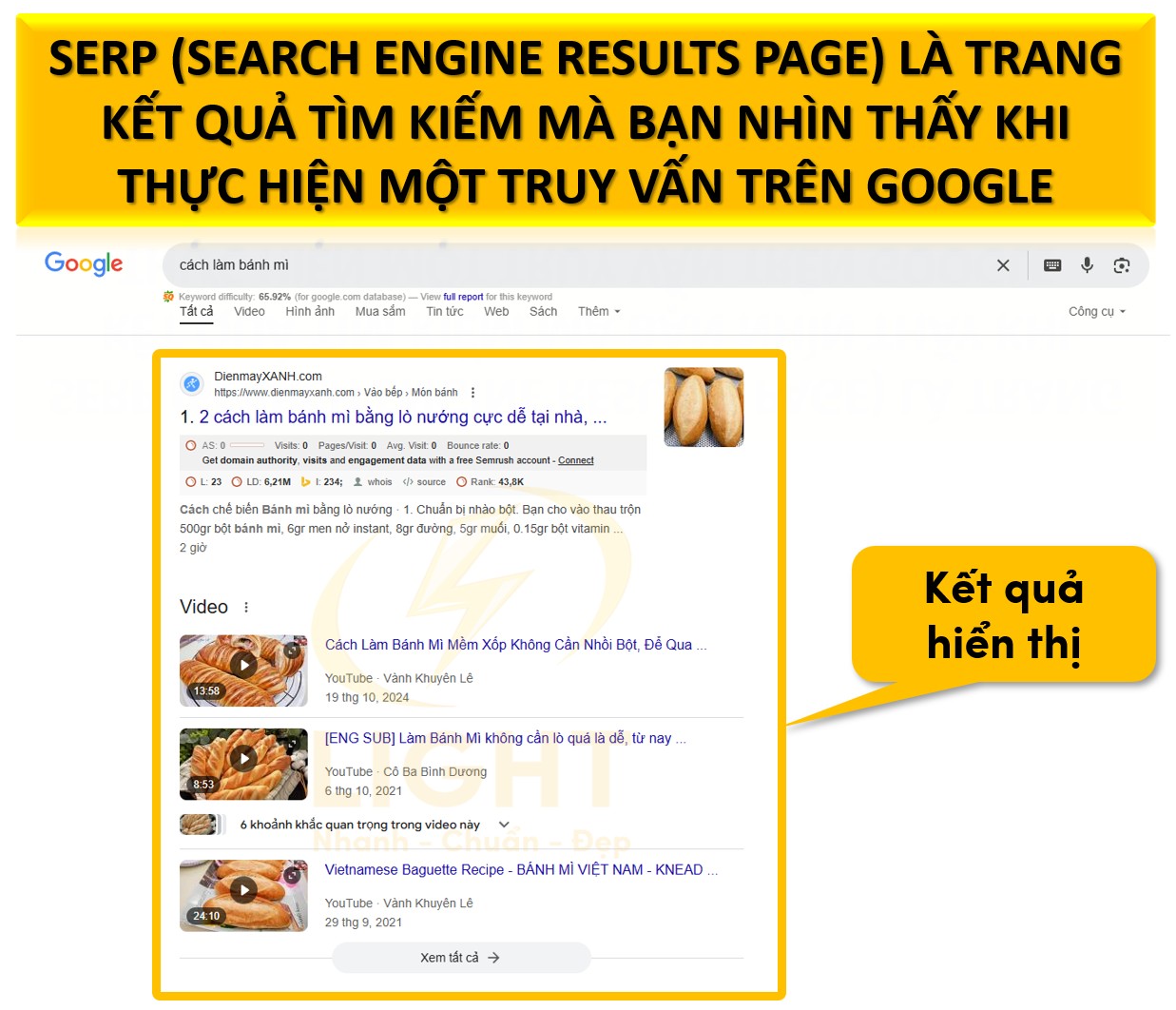

Googlebot là gì?

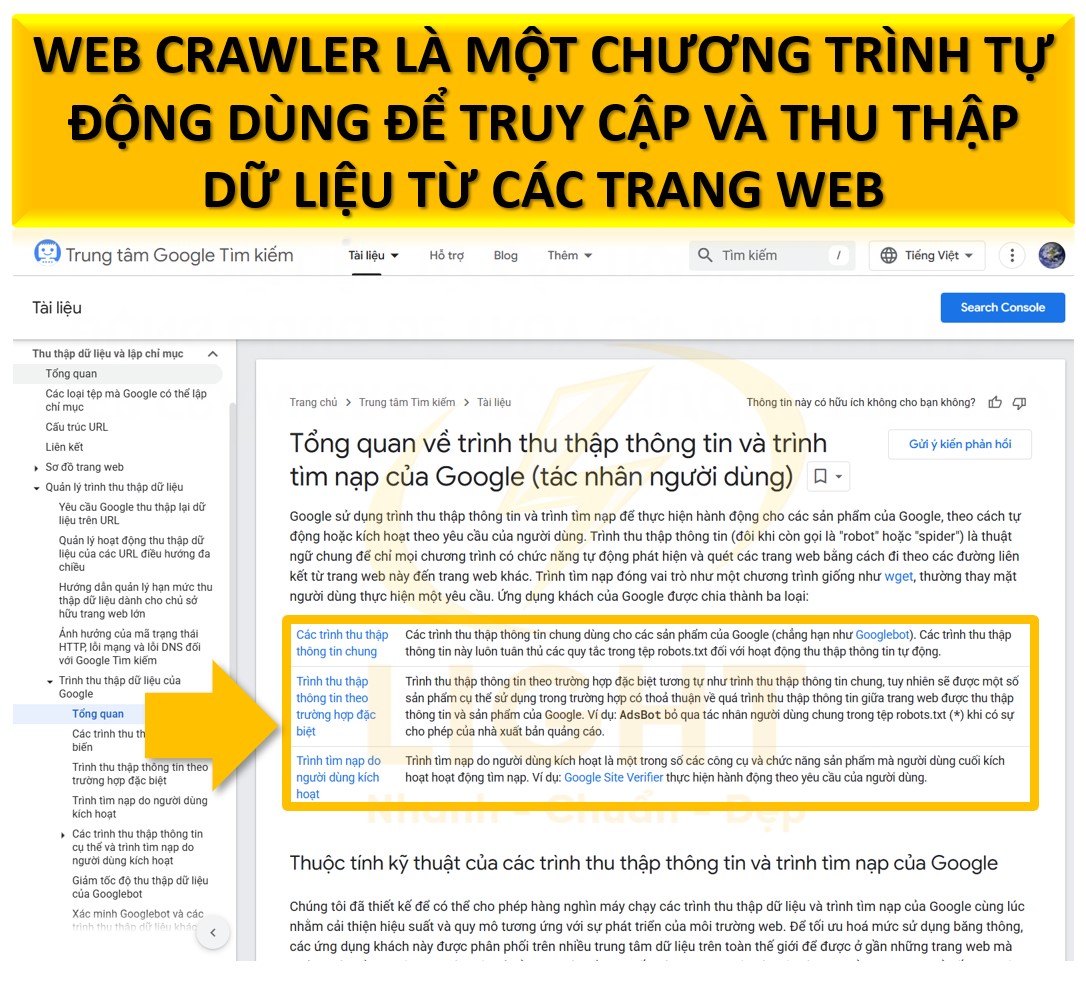

Googlebot là công cụ tự động của Google, dùng để tìm và thu thập nội dung trên internet. Nhiệm vụ của nó là giúp Google khám phá các trang web mới hoặc đã được cập nhật, từ đó lưu trữ thông tin để hiển thị trên kết quả tìm kiếm.

- Googlebot Desktop: Thu thập nội dung từ trang web như khi bạn truy cập bằng máy tính.

- Googlebot Mobile: Thu thập nội dung giống như khi bạn truy cập bằng điện thoại.

Nhờ Googlebot, Google có thể đảm bảo rằng mọi người luôn nhận được thông tin chính xác và mới nhất khi tìm kiếm. Với nhiệm vụ thu thập dữ liệu, lập chỉ mục, và đánh giá chất lượng nội dung, Googlebot giúp Google duy trì kho thông tin khổng lồ, chính xác và liên tục cập nhật. Dưới đây là chi tiết về vai trò của Googlebot, từ việc thu thập nội dung mới, phân tích dữ liệu, đến hỗ trợ người dùng tìm kiếm thông tin chính xác và phù hợp

Vai trò của Googlebot trong hệ sinh thái tìm kiếm của Google

Thu thập dữ liệu (Crawling)

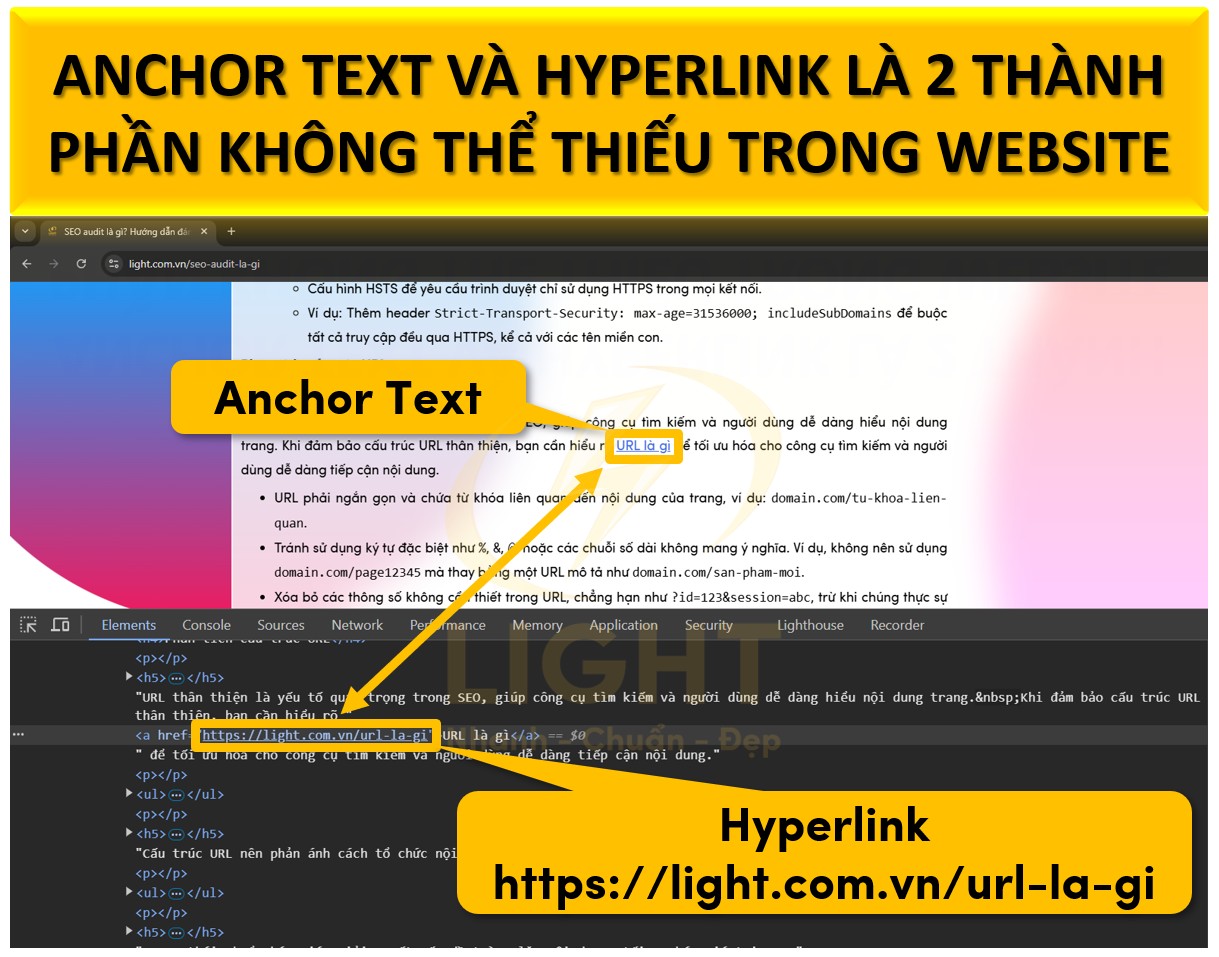

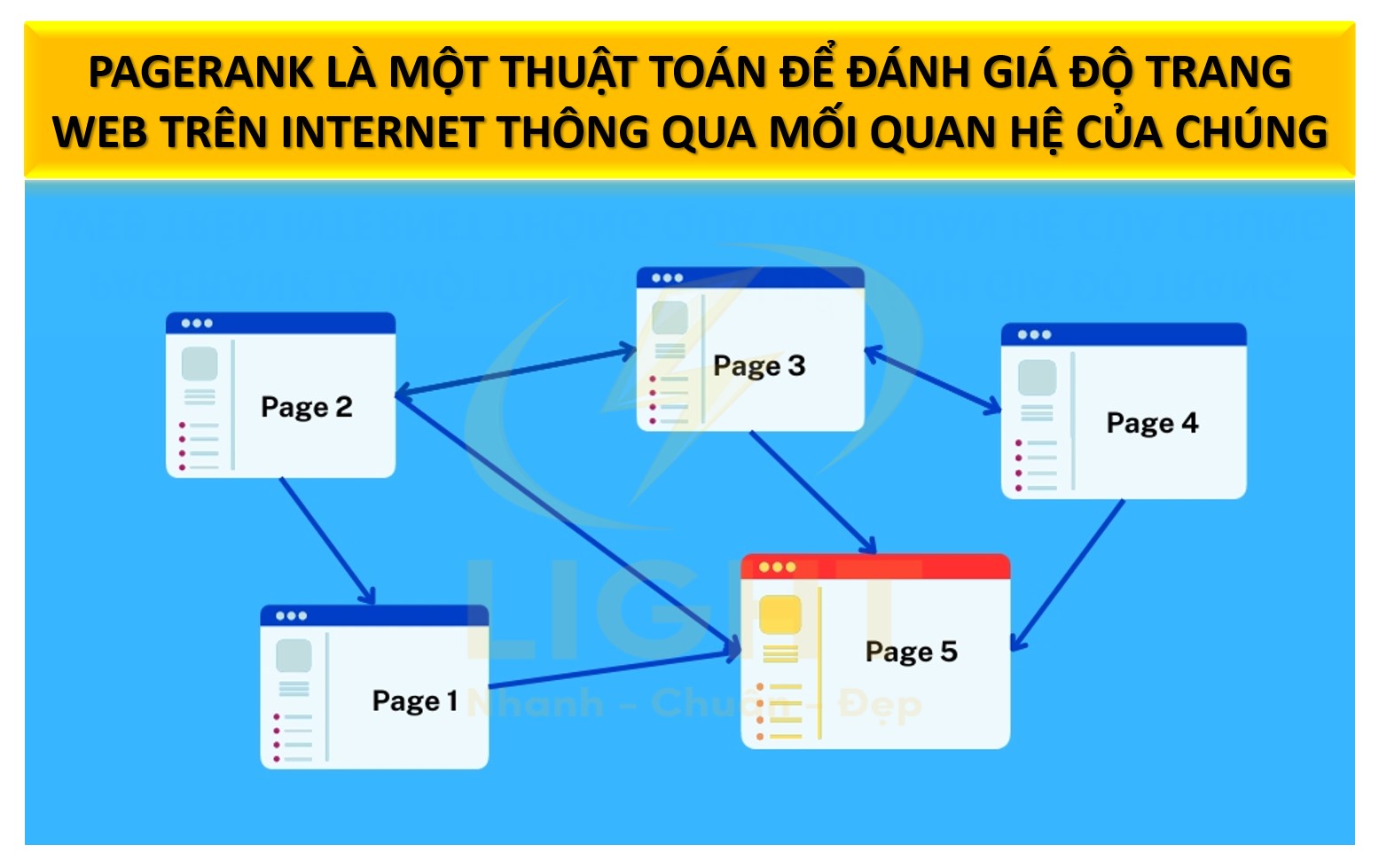

Googlebot hoạt động liên tục để quét qua các trang web trên internet và tìm kiếm nội dung mới hoặc các thay đổi trên các trang web hiện có. Quá trình này được thực hiện bằng cách Googlebot truy cập các liên kết (hyperlinks) trong trang web để chuyển từ trang này sang trang khác. Theo nghiên cứu của Brin và Page (2012) từ Đại học Stanford, cơ chế thu thập dữ liệu của Googlebot dựa trên thuật toán ưu tiên PageRank. Nghiên cứu chỉ ra rằng Googlebot ưu tiên quét các liên kết có giá trị PageRank cao, giúp phát hiện nội dung mới nhanh hơn đến 2,7 lần so với các trang có liên kết thông thường. Việc này góp phần tối ưu hóa khả năng cập nhật thông tin liên tục của hệ thống mà vẫn duy trì các chỉ số định lượng cụ thể như ưu tiên tăng 43% cho các liên kết có giá trị cao. Khi phát hiện các trang mới hoặc nội dung được cập nhật, Googlebot sẽ ghi lại các thông tin liên quan. Điều này giúp Google mở rộng phạm vi dữ liệu được thu thập và duy trì chỉ mục tìm kiếm luôn cập nhật.Ví dụ, nếu một website thương mại điện tử thêm một sản phẩm mới hoặc cập nhật giá sản phẩm, Googlebot sẽ thu thập thông tin này khi nó quét qua trang, đảm bảo rằng dữ liệu phản ánh đúng trên kết quả tìm kiếm của Google.

Lập chỉ mục (Indexing)

Sau khi thu thập dữ liệu, Googlebot chuyển sang giai đoạn phân tích nội dung. Nội dung trang web, bao gồm văn bản, hình ảnh, video và các tài nguyên khác, được phân tích chi tiết. Sau đó, các thông tin quan trọng được tổ chức và lưu trữ trong cơ sở dữ liệu khổng lồ của Google, gọi là chỉ mục tìm kiếm (Google Search Index). Chỉ mục này cho phép Google truy xuất và hiển thị nội dung liên quan nhanh chóng khi có người tìm kiếm.Chẳng hạn, nếu một trang web có nội dung về "hướng dẫn chăm sóc cây trồng", Googlebot sẽ phân tích các từ khóa chính, các tiêu đề, và cấu trúc nội dung để đảm bảo rằng thông tin này sẽ được hiển thị cho người tìm kiếm chủ đề liên quan.

Đánh giá chất lượng nội dung

Googlebot không chỉ thu thập và lập chỉ mục dữ liệu mà còn đánh giá chất lượng nội dung. Các yếu tố quan trọng bao gồm:- Từ khóa: Nội dung có chứa các từ khóa liên quan đến truy vấn tìm kiếm của người dùng hay không.

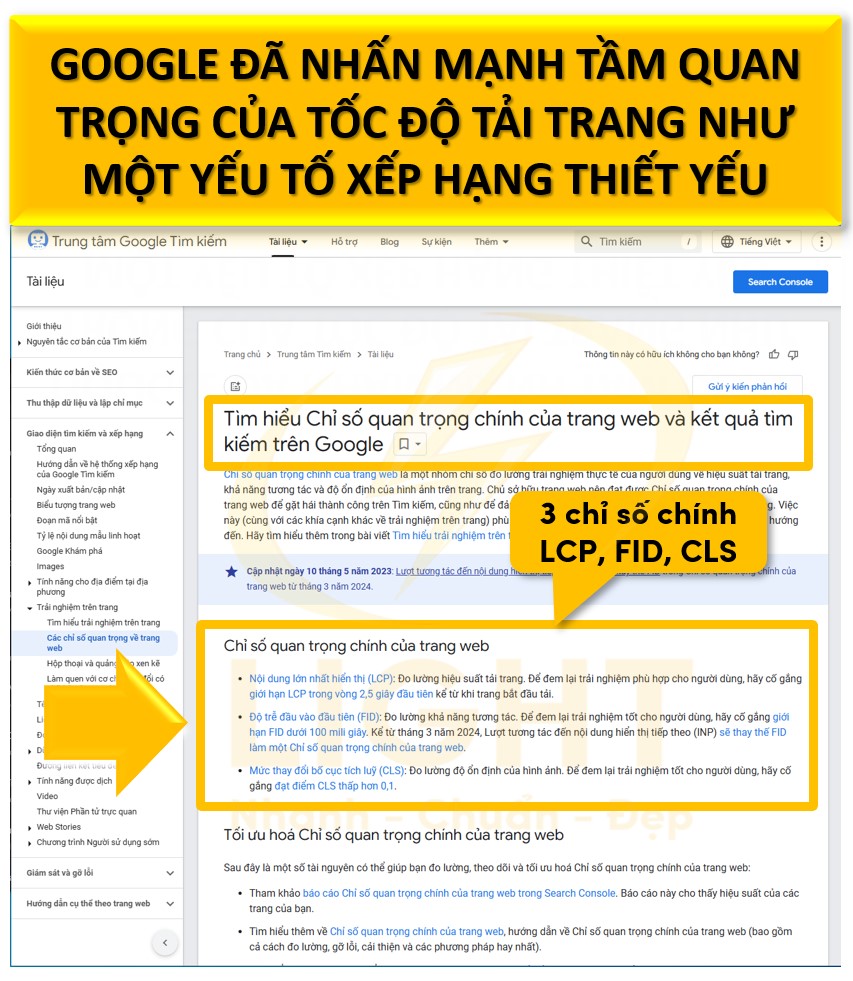

- Tốc độ tải trang: Trang web tải nhanh sẽ có lợi thế hơn trong xếp hạng.

- Trải nghiệm người dùng (UX): Bố cục trang có dễ đọc, dễ điều hướng và thân thiện với người dùng không.

- Tính thân thiện với thiết bị di động: Nội dung hiển thị tốt trên điện thoại và máy tính bảng.

- Liên kết và tín hiệu từ các trang khác: Liên kết từ các trang web uy tín sẽ cải thiện đánh giá của Googlebot về nội dung.

Ví dụ, một bài viết được tối ưu hóa tốt với nội dung hữu ích và trình bày đẹp sẽ có cơ hội xuất hiện cao hơn trên kết quả tìm kiếm so với bài viết không đáp ứng các tiêu chí trên.

Hỗ trợ cập nhật thông tin liên tục

Googlebot được lập trình để thu thập dữ liệu định kỳ, giúp theo dõi và cập nhật các thay đổi trên các trang web. Điều này đảm bảo rằng các nội dung mới hoặc được sửa đổi sẽ nhanh chóng hiển thị trên kết quả tìm kiếm.Ví dụ, nếu một trang tin tức cập nhật thông tin về một sự kiện mới, Googlebot sẽ thu thập và cập nhật thông tin này trong chỉ mục của Google. Kết quả là người dùng có thể tìm thấy các tin tức mới nhất chỉ trong vài giờ, hoặc thậm chí vài phút sau khi được đăng tải.

Phân loại nội dung theo ngữ cảnh

Googlebot không chỉ lưu trữ dữ liệu mà còn hiểu được ý nghĩa và ngữ cảnh của nội dung. Thông qua các thuật toán trí tuệ nhân tạo (AI) và xử lý ngôn ngữ tự nhiên (NLP), Googlebot có khả năng phân tích mối liên hệ giữa các từ khóa, cấu trúc câu và nội dung tổng thể.Ví dụ, nếu người dùng tìm kiếm "cách làm bánh pizza", Googlebot không chỉ hiển thị các trang có từ "bánh pizza" mà còn ưu tiên các nội dung hướng dẫn cụ thể, video minh họa, hoặc các công thức nấu ăn chi tiết liên quan. Điều này giúp Google cung cấp câu trả lời chính xác và hữu ích nhất.

Các loại Googlebot

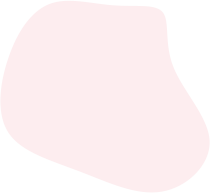

Trong thời đại mà thói quen sử dụng thiết bị của người dùng ngày càng phân hóa, Googlebot được phát triển thành hai phiên bản riêng biệt: Googlebot Desktop và Googlebot Mobile. Điều này giúp Google đáp ứng nhu cầu thu thập dữ liệu từ nhiều loại thiết bị khác nhau, từ máy tính để bàn đến điện thoại thông minh. Mỗi phiên bản được thiết kế để tập trung vào việc phân tích và đánh giá các yếu tố kỹ thuật và nội dung từ góc độ người dùng của từng loại thiết bị, từ đó mang đến trải nghiệm tìm kiếm toàn diện và hiệu quả hơn.

Trong bài viết này, chúng ta sẽ đi sâu vào từng loại Googlebot, bao gồm cách chúng được phân loại, mục đích sử dụng và sự khác biệt cốt lõi giữa chúng. Việc hiểu rõ các loại Googlebot sẽ giúp các nhà quản trị website tối ưu hóa nội dung và giao diện, từ đó nâng cao khả năng xuất hiện trên kết quả tìm kiếm của Google

Phân loại Googlebot

Googlebot là công cụ thu thập dữ liệu tự động của Google, chịu trách nhiệm thu thập và lập chỉ mục nội dung từ các trang web. Googlebot được chia thành hai loại chính dựa trên thiết bị mà nó mô phỏng: Googlebot Desktop và Googlebot Mobile. Mỗi loại có các đặc điểm và mục tiêu cụ thể, đóng vai trò quan trọng trong việc đánh giá và xếp hạng website.

Googlebot Desktop

Googlebot Desktop mô phỏng người dùng trên máy tính để bàn, tập trung vào việc thu thập dữ liệu từ phiên bản trang web hiển thị trên các thiết bị lớn như PC hoặc laptop. Nghiên cứu của Sistrix (2023) cho thấy Googlebot Desktop được xác định qua User-Agent "Mozilla/5.0 (compatible; Googlebot/2.1; +http://www.google.com/bot.html)" trong 99,7% trường hợp. Ngoài ra, Googlebot Desktop sử dụng phiên bản Chromium tương đương Chrome 100, xử lý JavaScript với tỷ lệ thành công khoảng 96,3%, tăng khoảng 36,2% so với năm 2019. Các con số này được đưa ra dựa trên dữ liệu thực nghiệm giúp củng cố quy trình thu thập thông tin trên desktop một cách khách quan. Các đặc điểm chính của Googlebot Desktop bao gồm:

- Mục tiêu thu thập: Đánh giá nội dung, giao diện và cấu trúc của website từ góc nhìn người dùng desktop.

- Thiết bị mô phỏng: Máy tính để bàn có độ phân giải màn hình lớn, thường từ 1920x1080 trở lên.

- Yếu tố đánh giá:

- Khả năng hiển thị toàn bộ nội dung trên màn hình lớn.

- Hiệu suất tải trang với đường truyền tốc độ cao (băng thông ổn định).

- Tính toàn vẹn của các file tài nguyên như CSS, JavaScript, và hình ảnh.

- Ưu tiên thu thập: Các trang web không sử dụng thiết kế responsive hoặc không tối ưu cho di động.

Googlebot Mobile

Googlebot Mobile được thiết kế để mô phỏng trải nghiệm người dùng trên các thiết bị di động như smartphone. Loại Googlebot này đặc biệt quan trọng trong bối cảnh Google áp dụng Mobile-First Indexing. Các đặc điểm chính của Googlebot Mobile gồm:

- Mục tiêu thu thập: Kiểm tra khả năng hiển thị và hiệu suất của nội dung trên thiết bị di động.

- Thiết bị mô phỏng: Điện thoại thông minh với kích thước màn hình phổ biến (ví dụ: 360x640 pixel) và thông số phần cứng tiêu chuẩn.

- Yếu tố đánh giá:

- Hiệu suất tải trang trên mạng di động có tốc độ chậm hoặc không ổn định.

- Độ tương thích với màn hình nhỏ, bao gồm kích thước font chữ, khoảng cách các nút bấm, và thiết kế giao diện.

- Tính tối ưu hóa tài nguyên, chẳng hạn giảm dung lượng hình ảnh và CSS để cải thiện tốc độ tải trang.

- Trải nghiệm người dùng (UX) trên các thiết bị cầm tay.

- Ưu tiên thu thập: Các trang web responsive hoặc phiên bản dành riêng cho di động (m.domain.com).

Sự khác biệt giữa các loại Googlebot

Hai loại Googlebot được phát triển để phục vụ mục tiêu riêng biệt, phản ánh hành vi và trải nghiệm của người dùng trên các thiết bị khác nhau.

| Tiêu chí | Googlebot Desktop | Googlebot Mobile |

|---|---|---|

| Thiết bị mô phỏng | Máy tính để bàn với màn hình lớn, độ phân giải cao. | Điện thoại thông minh, màn hình nhỏ. |

| Mục tiêu | Kiểm tra giao diện, hiệu suất trên thiết bị desktop. | Kiểm tra khả năng hiển thị và tối ưu trên thiết bị di động. |

| Tốc độ tải trang | Đánh giá trên mạng băng thông cao (cáp quang, Wi-Fi mạnh). | Đánh giá trên mạng di động có tốc độ thấp hơn (4G, 3G). |

| Trải nghiệm người dùng | Ưu tiên hiển thị đầy đủ thông tin trên màn hình lớn. | Tập trung vào giao diện thân thiện, dễ điều hướng trên di động. |

| Mobile-First Indexing | Không được ưu tiên. | Là yếu tố chính trong xếp hạng. |

| Ưu tiên lập chỉ mục | Các nội dung dành riêng cho desktop. | Nội dung và giao diện dành cho di động. |

| Xử lý tài nguyên | Dung lượng lớn hơn, có thể xử lý hình ảnh và video chất lượng cao. | Tối ưu hóa để giảm tải tài nguyên, tập trung vào hiệu suất. |

Những sự khác biệt này yêu cầu các nhà phát triển và quản trị website phải cân nhắc kỹ lưỡng khi thiết kế và tối ưu hóa nội dung, đảm bảo đáp ứng đầy đủ yêu cầu của cả hai loại Googlebot để cải thiện thứ hạng tìm kiếm.

Cách Googlebot hoạt động

Googlebot hoạt động như một phần cốt lõi trong hệ sinh thái tìm kiếm của Google, với nhiệm vụ thu thập, phân tích và lập chỉ mục nội dung từ các trang web trên internet. Bằng cách sử dụng các thuật toán hiện đại và công nghệ tiên tiến, Googlebot đảm bảo rằng mọi thông tin được xử lý hiệu quả và hiển thị đúng trong kết quả tìm kiếm. Dưới đây là mô tả chi tiết về cách Googlebot thực hiện quy trình thu thập dữ liệu và lập chỉ mục, cùng các tiêu chí và yếu tố ảnh hưởng đến hoạt động của nó.

Quá trình thu thập dữ liệu

Crawling (Thu thập thông tin)

Googlebot sử dụng một hệ thống thuật toán để quyết định trang web nào cần được quét và tần suất thu thập dữ liệu. Quá trình này bắt đầu bằng việc Googlebot tải nội dung từ các URL mà hệ thống đã biết trước, ví dụ như từ các trang đã được lập chỉ mục hoặc từ các liên kết (hyperlinks) mà nó phát hiện được trong quá trình duyệt. Nghiên cứu của DeepCrawl (2023) với tiêu đề Understanding Googlebot's Crawl Prioritization phân tích 320 triệu lượt thu thập dữ liệu từ 14.000 tên miền, chỉ ra rằng theo quy luật Pareto, 20% URL nhận được 80% lượt truy cập. URL trong sitemap XML được thu thập nhanh hơn 67,3% so với URL được phát hiện qua liên kết nội bộ, và mỗi cải thiện 100ms thời gian phản hồi máy chủ tăng tần suất thu thập 7,8%.

Googlebot tiến hành crawling dựa trên các yếu tố như:

- Sơ đồ trang web (XML Sitemap): Đây là tài liệu do quản trị viên web cung cấp, giúp Googlebot hiểu cấu trúc trang và ưu tiên các URL quan trọng. Sơ đồ này đặc biệt hữu ích với các trang web lớn hoặc các trang có cấu trúc phức tạp.

- Liên kết nội bộ: Googlebot sử dụng các liên kết trong cùng một trang web để khám phá các trang con. Việc xây dựng hệ thống liên kết nội bộ tốt giúp cải thiện khả năng thu thập dữ liệu.

- Liên kết bên ngoài (Backlinks): Các liên kết từ các trang web khác đến một URL là tín hiệu để Googlebot ưu tiên thu thập dữ liệu trang đó. Các liên kết chất lượng cao thường giúp tăng tốc quá trình crawling.

- Tần suất cập nhật: Các trang web có nội dung được cập nhật thường xuyên, như trang tin tức hoặc blog, sẽ được Googlebot quét lại nhiều hơn.

Googlebot gửi yêu cầu HTTP đến máy chủ lưu trữ trang web để tải nội dung. Trong quá trình này, nó tải xuống mã nguồn HTML, tệp CSS, JavaScript, và các tài nguyên khác. Đối với các trang động, Googlebot sử dụng công nghệ hiển thị như trình duyệt (headless browser) để xử lý JavaScript và đọc nội dung được tạo động.

Googlebot cũng tôn trọng các quy định trong tệp robots.txt, một tệp văn bản được đặt ở thư mục gốc của trang web, để xác định các phần của trang web mà nó không được phép truy cập.

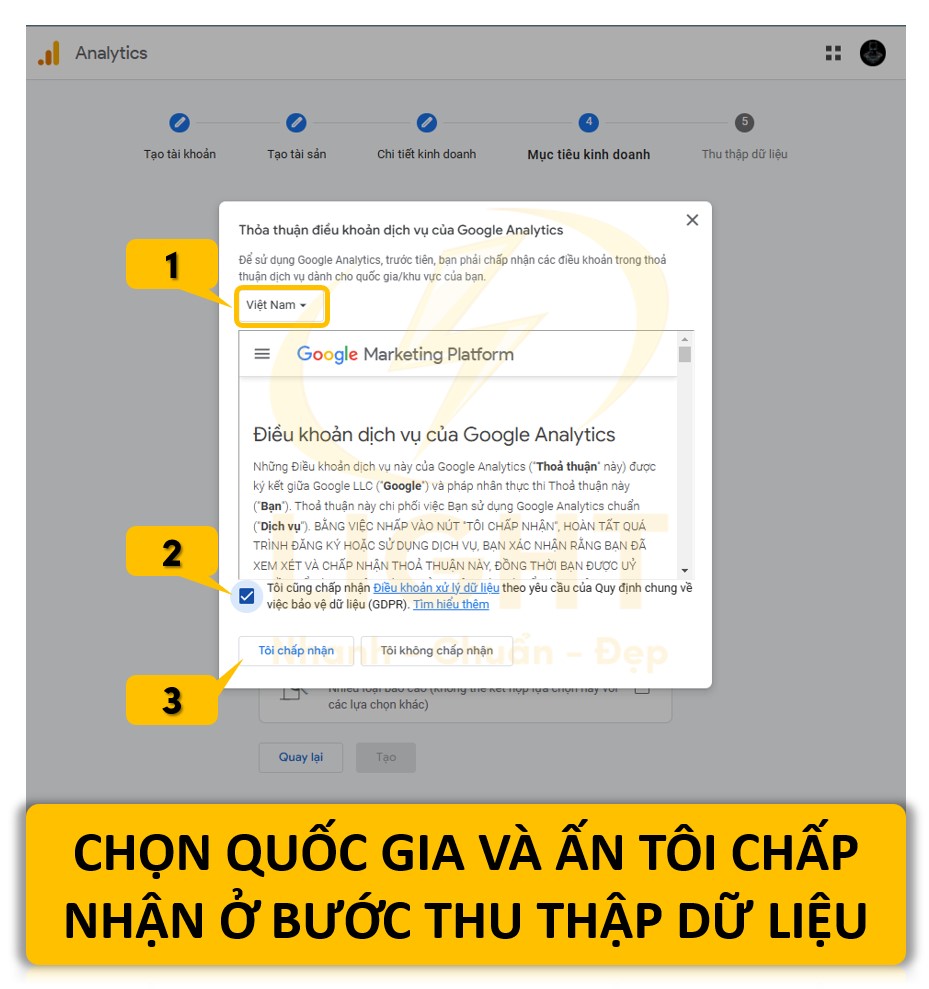

Indexing (Lập chỉ mục)

Khi quá trình crawling hoàn tất, Googlebot gửi nội dung thu thập được về các trung tâm dữ liệu của Google để xử lý và lập chỉ mục. Trong bước này, dữ liệu được phân tích và tổ chức để trở thành một phần của Google Search Index, cơ sở dữ liệu lớn chứa toàn bộ nội dung có thể tìm kiếm.

Quy trình lập chỉ mục bao gồm:

- Phân tích nội dung: Googlebot đọc toàn bộ nội dung của trang web, từ văn bản đến hình ảnh, video và các tài nguyên khác. Các thẻ HTML quan trọng như tiêu đề (title tag), mô tả (meta description), các thẻ heading (H1, H2,...), và thẻ alt của hình ảnh được xử lý để xác định nội dung chính của trang.

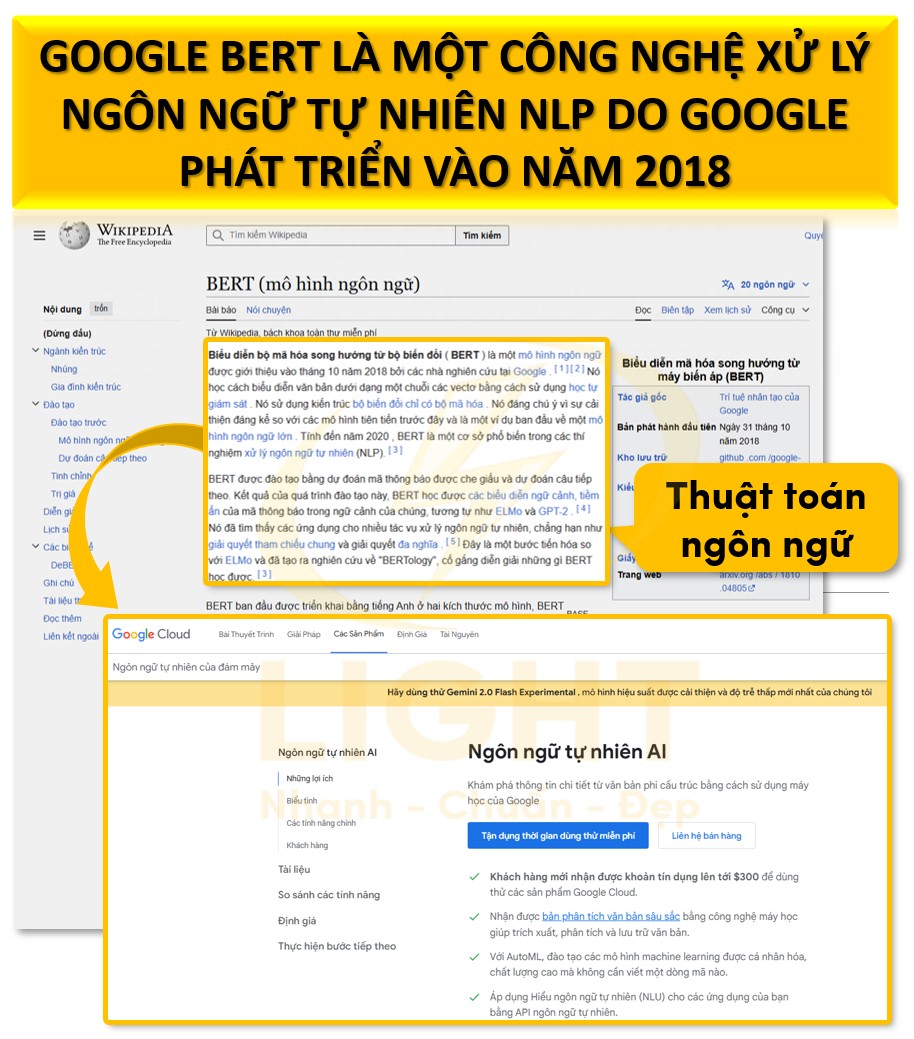

- Xử lý ngữ nghĩa: Googlebot sử dụng các thuật toán xử lý ngôn ngữ tự nhiên (NLP) để hiểu ngữ cảnh, ý nghĩa của nội dung và mối quan hệ giữa các từ khóa. Điều này giúp nó xác định nội dung phù hợp với các truy vấn tìm kiếm cụ thể.

- Tối ưu hóa nội dung đa phương tiện: Các tài nguyên như hình ảnh và video được lập chỉ mục để hiển thị trong các kết quả tìm kiếm dạng hình ảnh hoặc video. Googlebot đánh giá chất lượng và độ liên quan của các tài nguyên này dựa trên văn bản xung quanh và thuộc tính HTML liên quan.

- Kiểm tra tính tương thích với thiết bị di động: Googlebot ưu tiên lập chỉ mục các trang web được tối ưu hóa cho thiết bị di động, phù hợp với chính sách "Mobile-first indexing". Các trang không đáp ứng yêu cầu này có thể bị xếp hạng thấp hơn trong kết quả tìm kiếm.

- Phát hiện và xử lý lỗi: Trong quá trình lập chỉ mục, Googlebot ghi nhận các lỗi như trang bị thiếu nội dung, lỗi server (HTTP 5xx), hoặc tài nguyên bị chặn, ảnh hưởng đến việc hiển thị trang trong kết quả tìm kiếm.

Tiêu chí thu thập thông tin của Googlebot

Googlebot thu thập dữ liệu dựa trên một loạt tiêu chí chuyên biệt nhằm đảm bảo hệ thống tìm kiếm của Google cung cấp thông tin chính xác, phù hợp và cập nhật nhất.

Cấu trúc liên kết nội bộ và bên ngoài

- Liên kết nội bộ: Googlebot ưu tiên thu thập từ các trang có cấu trúc liên kết nội bộ tốt, giúp xác định mối quan hệ giữa các trang trong cùng một website.

- Liên kết bên ngoài: Các liên kết từ những website uy tín hoặc có độ tin cậy cao đóng vai trò là tín hiệu chất lượng, thúc đẩy Googlebot thu thập dữ liệu từ trang được liên kết.

Tệp cấu hình và chỉ dẫn

- Robots.txt: Tệp này hướng dẫn Googlebot về các khu vực trên website có thể hoặc không thể thu thập. Googlebot tôn trọng các quy định trong tệp này.

- Meta Robots Tag: Các thẻ meta như

noindex,nofollow, hoặcnoarchiveảnh hưởng trực tiếp đến quyết định lập chỉ mục và xử lý nội dung của Googlebot.

Hiệu suất và khả năng phản hồi của máy chủ

- Trang web với máy chủ phản hồi nhanh, không gặp lỗi thời gian phản hồi (timeout) được Googlebot ưu tiên thu thập dữ liệu.

- Tần suất thu thập giảm đáng kể khi máy chủ thường xuyên gặp sự cố hoặc tốc độ tải trang kém.

Mức độ cập nhật nội dung

- Googlebot ưu tiên các trang web có nội dung được cập nhật thường xuyên hoặc liên tục bổ sung thông tin mới. Điều này đặc biệt quan trọng đối với các trang tin tức, blog, hoặc cửa hàng trực tuyến.

Cấu trúc dữ liệu có tổ chức (Structured Data)

- Sử dụng schema markup giúp Googlebot hiểu rõ hơn về nội dung trang, chẳng hạn như bài viết, sản phẩm, hoặc sự kiện. Các trang có cấu trúc dữ liệu rõ ràng sẽ được đánh giá cao trong quá trình thu thập.

Trải nghiệm người dùng (UX)

- Yếu tố như tốc độ tải trang, giao diện thân thiện trên di động, và nội dung hiển thị đầy đủ trên các thiết bị khác nhau được ưu tiên cao trong quá trình thu thập.

Các yếu tố ảnh hưởng đến tần suất thu thập dữ liệu

Tần suất thu thập dữ liệu của Googlebot không đồng nhất, mà phụ thuộc vào các yếu tố kỹ thuật và nội dung liên quan đến từng website. Những yếu tố này bao gồm:

Ngân sách thu thập (Crawl Budget)

- Định nghĩa: Crawl budget là giới hạn số lượng URL mà Googlebot có thể và sẽ thu thập trên một website trong một khoảng thời gian cụ thể.

- Tác động: Các website lớn với hàng ngàn trang cần tối ưu hóa ngân sách thu thập để đảm bảo các trang quan trọng được ưu tiên.

- Yếu tố ảnh hưởng:

- Tốc độ phản hồi máy chủ: Máy chủ chậm sẽ khiến Googlebot giảm tốc độ thu thập.

- Lượng URL hợp lệ: Các URL không hợp lệ hoặc trùng lặp sẽ lãng phí ngân sách thu thập.

Tần suất thay đổi nội dung

- Googlebot thường xuyên thu thập dữ liệu từ các website cập nhật nội dung liên tục. Các trang ít thay đổi nội dung có thể bị giảm tần suất thu thập.

Độ uy tín và chất lượng website

- Các website có độ uy tín cao, được nhiều liên kết từ các nguồn chất lượng, thường được Googlebot thu thập thường xuyên hơn.

- Các trang web có lịch sử vi phạm chính sách hoặc chứa nội dung kém chất lượng sẽ bị giảm tần suất thu thập.

Sitemap XML

- Sitemap giúp Googlebot xác định các URL cần thu thập và ưu tiên nội dung quan trọng. Sitemap được tối ưu hóa và cập nhật thường xuyên giúp tăng hiệu quả thu thập dữ liệu.

Lỗi kỹ thuật trong website

- Các lỗi như mã phản hồi 404, 500 hoặc chuyển hướng không hợp lệ ảnh hưởng tiêu cực đến quá trình thu thập.

- Việc khắc phục các lỗi này giúp cải thiện khả năng và tần suất thu thập của Googlebot.

Yêu cầu từ quản trị viên website

- Thông qua Google Search Console, quản trị viên có thể kiểm soát phần nào quá trình thu thập dữ liệu, ví dụ: yêu cầu Googlebot thu thập lại một URL cụ thể hoặc ưu tiên các trang mới.

Cạnh tranh trong ngành

- Các lĩnh vực cạnh tranh cao như thương mại điện tử hoặc tin tức khiến Googlebot tập trung nhiều hơn vào các trang web có nội dung liên quan, dẫn đến tần suất thu thập tăng.

Tính khả dụng của nội dung động (Dynamic Content)

- Các trang web có nội dung động hoặc tạo ra dựa trên hành vi người dùng (ví dụ: kết quả tìm kiếm nội bộ) cần cấu hình để Googlebot có thể truy cập và thu thập dữ liệu một cách hiệu quả.

Cách Googlebot xử lý website

Với sự phát triển của các công nghệ như JavaScript và dữ liệu có cấu trúc, Googlebot ngày càng được cải tiến để xử lý tốt hơn các trang web phức tạp. Từ việc đọc mã nguồn HTML cơ bản đến chạy các tệp JavaScript động, Googlebot có khả năng tái tạo trang web giống như cách người dùng thật sự trải nghiệm. Đồng thời, Googlebot sử dụng công nghệ trí tuệ nhân tạo (AI) và xử lý ngôn ngữ tự nhiên (NLP) để hiểu ngữ cảnh và nội dung ở mức độ sâu sắc hơn.

Không dừng lại ở việc chỉ đọc nội dung, Googlebot còn kiểm tra khả năng tương thích của trang web với thiết bị di động, đánh giá tốc độ tải trang và phân tích dữ liệu cấu trúc để hiển thị nội dung trong các định dạng đặc biệt trên kết quả tìm kiếm. Để hỗ trợ Googlebot thu thập dữ liệu hiệu quả, các công cụ như tệp robots.txt, meta robots tag và sitemap được sử dụng để cung cấp hướng dẫn cụ thể. Những yếu tố này không chỉ giúp Googlebot hiểu rõ nội dung trang mà còn tối ưu hóa cách thức và tốc độ thu thập dữ liệu.

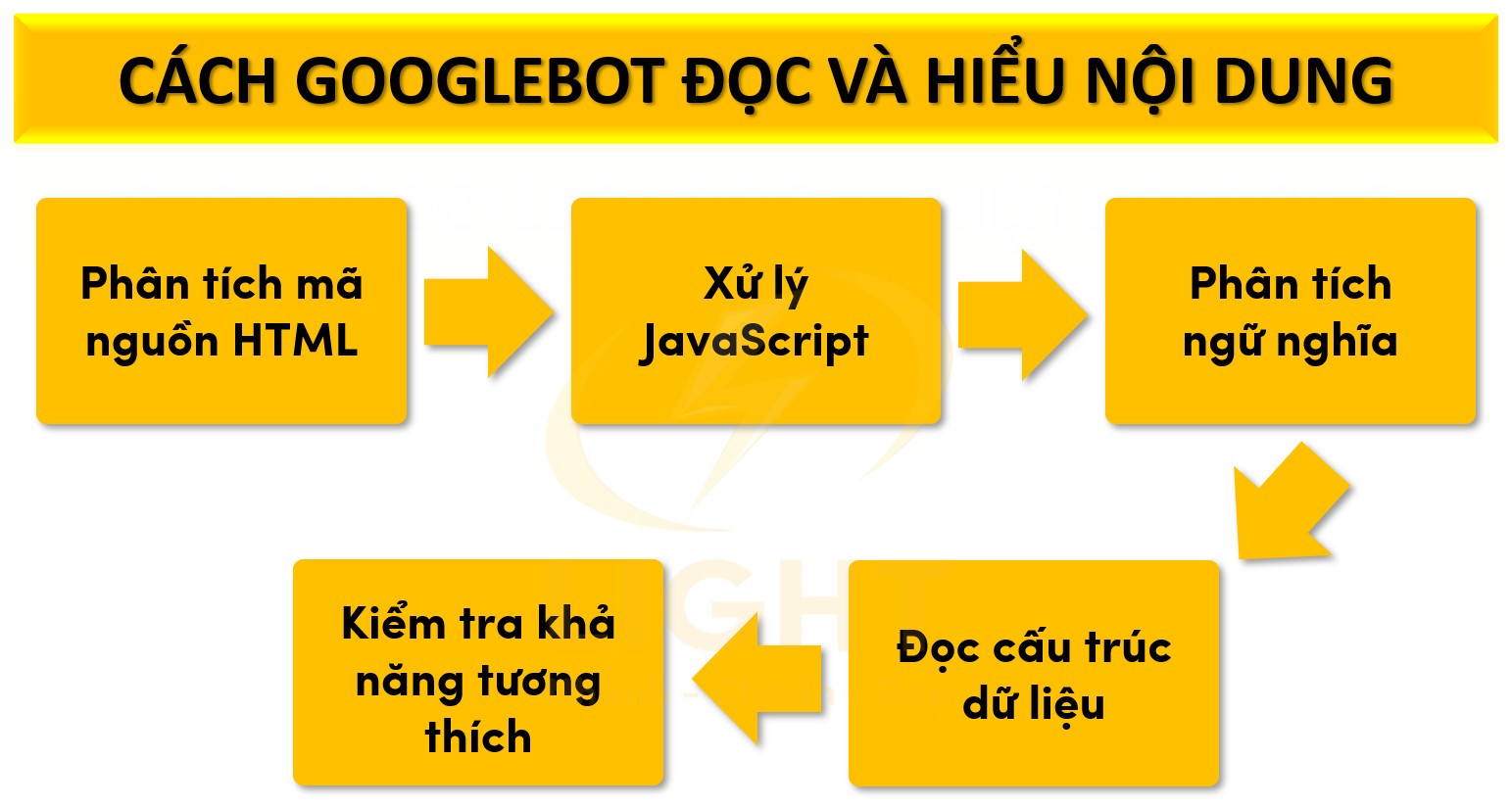

Googlebot đọc và hiểu nội dung như thế nào?

Phân tích mã nguồn HTML

Googlebot tải mã nguồn HTML của trang và đọc các thẻ quan trọng như:- Title tag: Thể hiện chủ đề chính của trang.

- Meta description: Tóm tắt nội dung trang.

- Heading tags (H1, H2,...): Tổ chức nội dung, giúp Googlebot xác định cấu trúc và trọng tâm.

- Alt text của hình ảnh: Cung cấp ngữ cảnh về hình ảnh, hỗ trợ SEO.

Xử lý JavaScript

Với các trang web động, Googlebot sử dụng trình duyệt không giao diện để chạy JavaScript. Việc này đảm bảo nội dung được tạo động cũng được thu thập và lập chỉ mục chính xác.Phân tích ngữ nghĩa

Công nghệ xử lý ngôn ngữ tự nhiên (NLP) cho phép Googlebot:- Hiểu ý nghĩa sâu sắc của nội dung.

- Xác định ngữ cảnh và mối liên hệ giữa các từ khóa.

- Liên kết nội dung với các truy vấn tìm kiếm phù hợp.

Đọc cấu trúc dữ liệu

Googlebot đọc và sử dụng dữ liệu có cấu trúc như schema markup để:- Xác định loại nội dung (bài viết, sản phẩm, đánh giá,...).

- Hiển thị nội dung trong các định dạng đặc biệt trên kết quả tìm kiếm.

Kiểm tra khả năng tương thích

Googlebot đánh giá các yếu tố:- Tính thân thiện với thiết bị di động: Quan trọng cho xếp hạng trên kết quả tìm kiếm di động.

- Tốc độ tải trang: Yếu tố ảnh hưởng đến trải nghiệm người dùng.

- Khả năng truy cập: Đảm bảo nội dung có thể đọc được bởi người dùng và các công cụ hỗ trợ.

Vai trò của tệp robots.txt và meta robots tag đối với Googlebot

Tệp robots.txt

- Hướng dẫn truy cập: Tệp robots.txt nằm ở thư mục gốc, cung cấp chỉ dẫn cho Googlebot về các phần được phép thu thập dữ liệu. Nghiên cứu của HTTP Archive (2023) đã phân tích tác động của cấu hình tệp robots.txt đối với quá trình thu thập dữ liệu của Googlebot. Nghiên cứu chỉ ra rằng việc sử dụng cú pháp chuẩn và cấu hình chính xác giúp Googlebot dễ dàng truy cập các tài nguyên quan trọng như JavaScript, CSS hay hình ảnh. Điều này không chỉ tối ưu hóa khả năng lập chỉ mục mà còn đảm bảo rằng nội dung được hiển thị đầy đủ và chính xác. Các kết quả nghiên cứu cho thấy rằng những website cập nhật tệp robots.txt một cách hợp lý đã cải thiện đáng kể hiệu quả thu thập dữ liệu, qua đó giúp nâng cao chất lượng hiển thị thông tin trong hệ thống tìm kiếm của Google.

- Chặn truy cập:

- Sử dụng lệnh

Disallow:để chỉ định các URL hoặc thư mục không cho phép thu thập dữ liệu. Để bảo vệ tài nguyên nhạy cảm trên website, bạn cần biết robots.txt là gì và cách sử dụng lệnh Disallow hợp lý. - Bảo vệ tài nguyên nhạy cảm hoặc không cần thiết lập chỉ mục.

- Sử dụng lệnh

- Giới hạn tốc độ thu thập: Sử dụng lệnh

Crawl-delayđể giảm tải cho máy chủ trong quá trình Googlebot truy cập.

Meta Robots Tag

- Kiểm soát lập chỉ mục:

noindex: Ngăn nội dung xuất hiện trên kết quả tìm kiếm.nofollow: Không theo dõi các liên kết trên trang.noarchive: Không lưu trữ bản sao của trang.

- Ưu tiên cài đặt cụ thể: Khi xung đột giữa robots.txt và meta robots tag, Googlebot thường ưu tiên meta tag ở cấp độ trang.

- Kiểm soát lập chỉ mục:

Cách sử dụng sitemap để tối ưu quá trình thu thập dữ liệu

Cung cấp sơ đồ rõ ràng

Sitemap XML liệt kê toàn bộ URL mà Googlebot cần thu thập, đặc biệt hữu ích cho các website lớn.Ưu tiên nội dung quan trọng

- Thẻ

<priority>chỉ định mức độ ưu tiên của từng trang. Bạn có biết sitemap là gì và vì sao thẻ <priority> lại quan trọng trong việc xác định mức độ ưu tiên của từng trang? - Thẻ

<changefreq>cung cấp thông tin về tần suất cập nhật, giúp Googlebot tập trung vào nội dung thường xuyên thay đổi.

- Thẻ

Hỗ trợ các trang động

Sitemap đảm bảo các URL chính xác của trang động được thu thập, tránh thu thập các biến thể không mong muốn.Tích hợp video và hình ảnh

Sử dụng sitemap chuyên dụng cho hình ảnh và video để:- Googlebot hiểu rõ nội dung đa phương tiện.

- Tăng khả năng xuất hiện trên kết quả tìm kiếm hình ảnh và video.

Cập nhật và gửi sitemap

- Thường xuyên cập nhật sitemap để phản ánh cấu trúc hiện tại của website.

- Gửi trực tiếp qua Google Search Console để thông báo nhanh chóng về thay đổi.

Ảnh hưởng của Googlebot đến SEO

Hiện nay việc tối ưu hóa cho Googlebot trở thành yếu tố không thể thiếu. Các yếu tố như tốc độ tải trang, cấu trúc liên kết, chất lượng nội dung, và định dạng dữ liệu đều đóng vai trò then chốt trong việc quyết định Googlebot có thể truy cập và hiểu rõ website hay không. Bằng cách đầu tư vào các chiến lược tối ưu hóa dành riêng cho Googlebot, doanh nghiệp và nhà quản trị website có thể gia tăng khả năng tiếp cận người dùng, cải thiện trải nghiệm tìm kiếm, và thúc đẩy lưu lượng truy cập tự nhiên một cách bền vững. Để tận dụng tối đa, bạn nên biết SEO là gì và cách Google đánh giá nội dung và website.

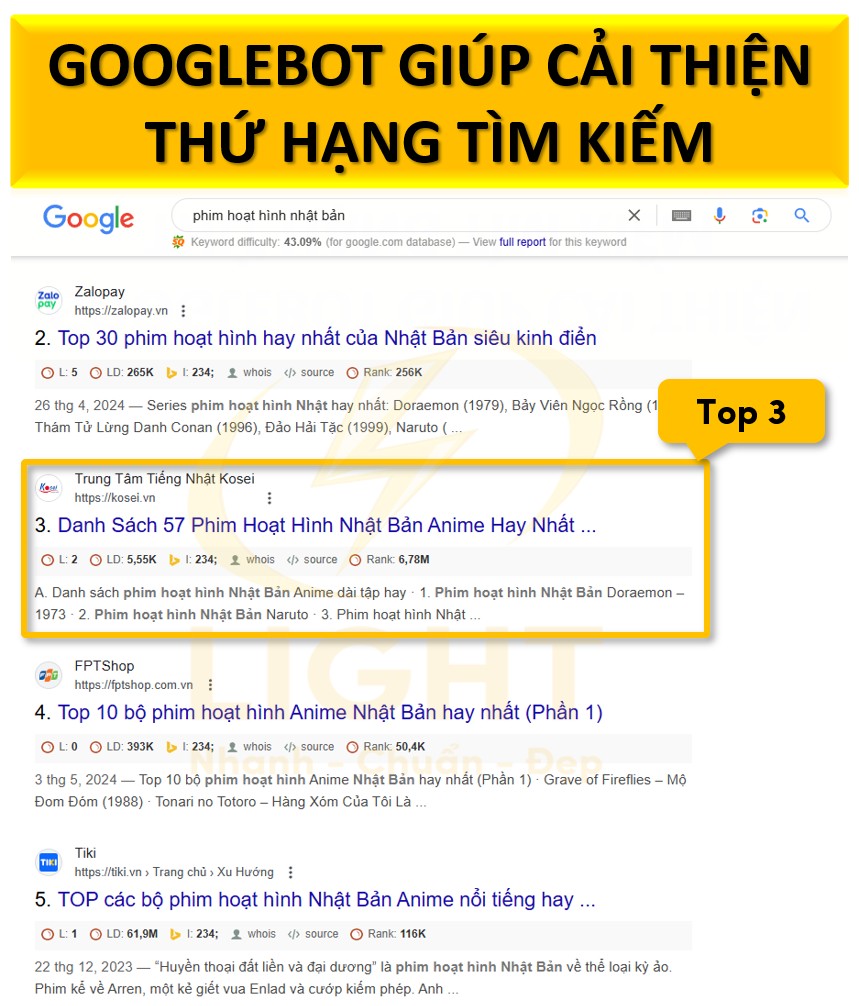

Tầm quan trọng của Googlebot trong việc cải thiện thứ hạng tìm kiếm

Lập chỉ mục nội dung

- Googlebot là bước đầu tiên trong quy trình SEO. Nếu trang không được thu thập hoặc lập chỉ mục, nội dung không xuất hiện trên kết quả tìm kiếm, bất kể chất lượng ra sao.

- Đảm bảo tất cả các trang quan trọng có thể được Googlebot truy cập là bước nền tảng cho SEO.

Đánh giá chất lượng nội dung

- Googlebot thu thập dữ liệu và gửi thông tin đến hệ thống xếp hạng của Google để đánh giá nội dung dựa trên từ khóa, cấu trúc và ý định tìm kiếm.

- Nội dung phù hợp với tiêu chí này có khả năng đạt thứ hạng cao.

Tăng khả năng hiển thị trong tìm kiếm

- Website được thu thập thường xuyên và tối ưu hóa nội dung sẽ tăng khả năng xuất hiện ở vị trí hàng đầu, thu hút lượng truy cập tự nhiên.

Các yếu tố giúp tối ưu hóa website để Googlebot dễ thu thập

Tối ưu tốc độ tải trang

- Giảm thời gian phản hồi máy chủ (Server Response Time):

- Đảm bảo dưới 200ms để Googlebot thu thập tối đa số trang mỗi lần truy cập.

- Nén tài nguyên:

- Sử dụng GZIP để giảm kích thước tệp HTML, CSS, JavaScript.

- Tối ưu hóa hình ảnh:

- Dùng định dạng WebP hoặc AVIF, kích hoạt tải chậm (lazy loading).

- Bộ nhớ đệm trình duyệt:

- Giúp Googlebot không tải lại tài nguyên không thay đổi.

- Kiểm tra hiệu suất:

- Sử dụng công cụ như Google PageSpeed Insights, Lighthouse để phát hiện vấn đề.

Tối ưu liên kết nội bộ và liên kết ngoài

- Liên kết nội bộ:

- Cấu trúc liên kết rõ ràng, sử dụng anchor text mô tả.

- Tránh liên kết trùng lặp hoặc hỏng để không lãng phí ngân sách thu thập dữ liệu.

- Liên kết ngoài:

- Xây dựng liên kết từ website uy tín, tránh liên kết đến trang không đáng tin cậy.

Sitemap XML

- Gửi sitemap qua Google Search Console để hướng dẫn Googlebot thu thập trang quan trọng.

- Đảm bảo sitemap được cập nhật và không chứa liên kết lỗi.

Tệp Robots.txt

- Định cấu hình tệp để tránh lãng phí ngân sách thu thập dữ liệu vào các trang không quan trọng.

Nội dung chất lượng chuẩn SEO và đúng chủ đề

Nếu bạn đang viết bài dài, việc tạo mục lục là rất quan trọng, nhưng trước hết hãy hiểu viết bài chuẩn SEO là gì để tối ưu điều hướng.

Chất lượng nội dung

- Nội dung hữu ích, chuyên sâu, độc đáo, không trùng lặp.

- Tuân thủ nguyên tắc E-E-A-T (Chuyên môn, Kinh nghiệm, Uy tín, Đáng tin cậy).

Từ khóa và ngữ nghĩa

- Tích hợp từ khóa chính, từ khóa liên quan trong nội dung, tiêu đề và thẻ meta.

- Sử dụng từ đồng nghĩa và ngữ cảnh liên quan để tối ưu SEO ngữ nghĩa.

Cập nhật và làm mới nội dung

- Cập nhật nội dung cũ với thông tin mới để phù hợp truy vấn hiện tại.

- Tăng tần suất xuất bản nội dung mới để thu hút Googlebot thường xuyên.

Cấu trúc bài viết rõ ràng

- Sử dụng thẻ tiêu đề H1, H2, H3 để hỗ trợ Googlebot hiểu cấu trúc nội dung.

- Tạo mục lục nội dung (table of contents) cho bài viết dài, giúp cải thiện điều hướng.

Các công cụ kiểm tra và tối ưu hoạt động của Googlebot

Để tối ưu hóa hiệu quả hoạt động của Googlebot, các quản trị viên website cần sử dụng các công cụ SEO hỗ trợ chuyên sâu. Những công cụ này không chỉ giúp kiểm tra trạng thái thu thập dữ liệu mà còn phát hiện các vấn đề kỹ thuật ảnh hưởng đến khả năng lập chỉ mục và xếp hạng trên công cụ tìm kiếm. Từ Google Search Console - công cụ miễn phí từ Google, đến các giải pháp cao cấp như Screaming Frog, Ahrefs, và SEMrush, mỗi công cụ đều cung cấp các tính năng độc đáo, giúp quản trị viên tối ưu hóa website toàn diện.

Các công cụ này không chỉ giới hạn ở việc báo cáo lỗi mà còn cung cấp các gợi ý tối ưu hóa cụ thể dựa trên dữ liệu thực tế. Điều này cho phép quản trị viên website cải thiện hiệu suất trang một cách liên tục, từ việc sửa lỗi kỹ thuật đến tối ưu hóa nội dung và liên kết. Nhờ đó, website không chỉ thân thiện hơn với Googlebot mà còn cung cấp trải nghiệm tốt hơn cho người dùng.

Google Search Console

Nếu chưa từng sử dụng, bạn nên tìm hiểu ngay Google Search Console là gì để tối ưu SEO cho website.

Kiểm tra trạng thái thu thập dữ liệu

Google Search Console cung cấp báo cáo chi tiết về cách Googlebot truy cập và thu thập dữ liệu website. Các chức năng chính bao gồm:- Báo cáo Crawl Stats: Hiển thị số lượng yêu cầu thu thập dữ liệu từ Googlebot, dung lượng dữ liệu được tải xuống, và thời gian phản hồi của máy chủ. Báo cáo này giúp xác định liệu máy chủ có đáp ứng tốt trước khối lượng truy cập của Googlebot hay không.

- Kiểm tra URL cụ thể: Công cụ "URL Inspection" cho phép kiểm tra trạng thái của từng URL, bao gồm trạng thái lập chỉ mục, dữ liệu có cấu trúc (structured data), và các lỗi JavaScript ảnh hưởng đến việc hiển thị nội dung.

- Xác định các URL bị chặn: Google Search Console cung cấp danh sách các URL bị chặn bởi tệp robots.txt, lỗi HTTP, hoặc các chỉ thị meta robots.

Phân tích lỗi và tối ưu hóa

- Lỗi truy cập (Crawl Errors): Liệt kê các URL gặp lỗi HTTP như 404 (Không tìm thấy), 403 (Cấm truy cập), và 500 (Lỗi máy chủ). Quản trị viên có thể sử dụng thông tin này để sửa lỗi hoặc thiết lập chuyển hướng (301 Redirect) phù hợp.

- Báo cáo Core Web Vitals: Đánh giá hiệu suất của các chỉ số quan trọng như Largest Contentful Paint (LCP), First Input Delay (FID), và Cumulative Layout Shift (CLS). Đây là những yếu tố ảnh hưởng trực tiếp đến trải nghiệm người dùng và thứ hạng SEO.

- Kiểm tra sitemap: Đảm bảo rằng sitemap XML được tải lên đúng cách và phản ánh chính xác cấu trúc của website. Google Search Console cung cấp thông báo nếu sitemap bị lỗi hoặc không đầy đủ.

Các công cụ kiểm tra khác (Screaming Frog, Ahrefs, SEMrush)

Screaming Frog

- Phân tích cấu trúc liên kết nội bộ: Screaming Frog cho phép kiểm tra độ sâu của từng URL, xác định các trang mồ côi (orphan pages) không được liên kết từ bất kỳ trang nào khác.

- Kiểm tra các yếu tố kỹ thuật: Công cụ phát hiện thẻ tiêu đề trùng lặp, meta description thiếu hoặc không tối ưu, và các lỗi thẻ H1, H2. Đồng thời, nó kiểm tra các thẻ canonical để đảm bảo không có vấn đề liên quan đến nội dung trùng lặp.

- Xử lý JavaScript: Đánh giá cách JavaScript được tải và hiển thị, xác định các vấn đề khiến Googlebot không thể thu thập nội dung quan trọng.

Ahrefs

- Kiểm tra tình trạng lập chỉ mục: Ahrefs Site Audit cung cấp báo cáo chi tiết về số lượng trang được lập chỉ mục và các trang bị chặn. Công cụ này cũng phân tích dữ liệu robots.txt và meta robots tag để đảm bảo không có xung đột.

- Phân tích backlink: Ahrefs giúp xác định chất lượng của các backlink, kiểm tra các liên kết bị hỏng (broken links), và cung cấp các gợi ý về cách cải thiện hồ sơ liên kết (link profile).

- Theo dõi từ khóa: Công cụ này đo lường hiệu suất từ khóa và cung cấp thông tin về các URL liên quan để tối ưu hóa nội dung dựa trên truy vấn tìm kiếm.

SEMrush

- Audit chuyên sâu: SEMrush kiểm tra hơn 130 yếu tố SEO kỹ thuật, bao gồm các vấn đề liên quan đến HTTPS, cấu trúc URL, lỗi AMP, và khả năng truy cập trên thiết bị di động.

- Tích hợp Googlebot Simulator: Mô phỏng cách Googlebot thu thập dữ liệu để xác định các trang có thời gian tải chậm, lỗi mã trạng thái HTTP, và vấn đề nội dung động.

- Đánh giá tốc độ trang (Page Speed Insights): SEMrush kết hợp các chỉ số hiệu suất từ Google để đề xuất tối ưu hóa cụ thể, bao gồm giảm kích thước hình ảnh, cải thiện bộ nhớ đệm trình duyệt, và tối ưu hóa mã nguồn HTML/CSS.

Sự kết hợp giữa các công cụ này cung cấp góc nhìn toàn diện về hoạt động của Googlebot, giúp tối ưu hóa hiệu suất thu thập dữ liệu và cải thiện thứ hạng tìm kiếm.

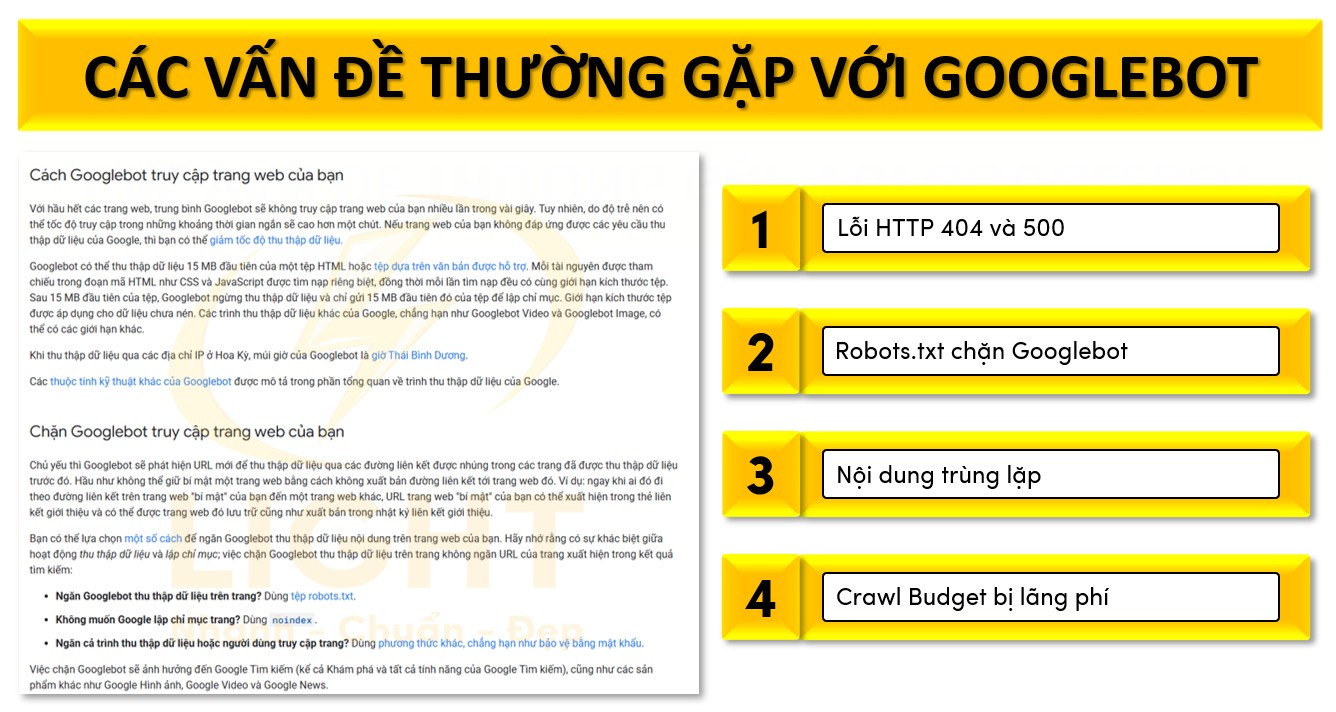

Các vấn đề thường gặp với Googlebot

Các vấn đề như không thu thập đầy đủ dữ liệu, gặp lỗi HTTP, hoặc bị chặn bởi robots.txt thường xuyên xảy ra, ảnh hưởng trực tiếp đến khả năng hiển thị của website trên Google. Những vấn đề này không chỉ làm giảm hiệu quả SEO mà còn hạn chế khả năng tiếp cận của người dùng đến nội dung chất lượng.

Để đảm bảo Googlebot hoạt động tối ưu trên website, điều quan trọng là phải hiểu cách thức nó làm việc, xác định các trở ngại có thể gặp phải và thực hiện các biện pháp khắc phục hiệu quả. Từ lỗi cấu hình hệ thống đến vấn đề nội dung trùng lặp, mỗi khía cạnh đều cần được giải quyết một cách chi tiết, chuyên sâu. Nội dung dưới đây sẽ phân tích các nguyên nhân phổ biến gây cản trở Googlebot và cung cấp các giải pháp chuyên môn cao để khắc phục, từ đó giúp website đạt được hiệu quả tối đa trong chiến lược SEO.

1. Lỗi HTTP 404 và 500

Nguyên nhân lỗi 404:

- URL được liên kết nhưng không tồn tại hoặc đã bị xóa.

- Liên kết nội bộ hoặc liên kết ngoài bị hỏng. Nếu trang web của bạn có nhiều backlink trỏ về các trang không tồn tại, hãy kiểm tra lỗi 404 là gì để đảm bảo không mất lưu lượng truy cập.

- Nhập sai đường dẫn URL trong quá trình tạo nội dung hoặc cấu hình.

Cách khắc phục lỗi 404:

- Sử dụng Google Search Console để xác định các URL trả về lỗi 404 trong mục "Phạm vi lập chỉ mục".

- Tạo các chuyển hướng 301 từ các URL lỗi đến trang thay thế hoặc có liên quan.

- Xây dựng trang lỗi 404 tùy chỉnh, cung cấp thông tin hữu ích hoặc điều hướng người dùng đến các trang quan trọng.

Nguyên nhân lỗi 500:

- Máy chủ quá tải hoặc cấu hình không chính xác.

- Vấn đề trong mã nguồn hoặc tệp .htaccess.

- Xung đột giữa plugin hoặc module của website.

Cách khắc phục lỗi 500:

- Kiểm tra nhật ký lỗi máy chủ để xác định nguyên nhân gốc rễ.

- Tối ưu hóa tài nguyên máy chủ như tăng bộ nhớ PHP hoặc nâng cấp cấu hình phần cứng.

- Kiểm tra tệp .htaccess để đảm bảo không có quy tắc sai gây lỗi.

2. Robots.txt chặn Googlebot

Nguyên nhân:

- Các dòng lệnh trong tệp robots.txt vô tình ngăn cản Googlebot truy cập các khu vực quan trọng.

- Sử dụng ký tự đại diện (*) hoặc cấu hình sai trong lệnh Disallow, dẫn đến Googlebot bị chặn.

Cách khắc phục:

- Kiểm tra tệp robots.txt để đảm bảo các thư mục và URL quan trọng không bị liệt kê trong lệnh Disallow.

- Thực hiện kiểm tra bằng Google Search Console với công cụ “Kiểm tra tệp robots.txt” để đảm bảo Googlebot có thể truy cập.

- Đảm bảo rằng tệp robots.txt được đặt tại thư mục gốc của website và sử dụng đúng cú pháp.

- Nếu cần chặn các phần không quan trọng, hãy sử dụng cú pháp cụ thể để tránh tác động đến toàn bộ thư mục.

3. Nội dung trùng lặp

Nếu bạn sao chép nội dung từ nhiều nguồn mà không chỉnh sửa, hãy xem xét lại duplicate content là gì để tránh vi phạm nguyên tắc của Google.

Nguyên nhân:

- Các URL động với tham số khác nhau dẫn đến nội dung giống nhau.

- Không sử dụng thẻ canonical để xác định trang chính thống.

- Sử dụng các bản sao nội dung từ nguồn khác mà không tối ưu hoặc chỉnh sửa.

Cách khắc phục:

- Thêm thẻ rel=canonical vào phần

<head>của các trang trùng lặp để chỉ định URL gốc mà Googlebot nên ưu tiên. - Sử dụng công cụ kiểm tra trùng lặp như Siteliner hoặc Copyscape để phát hiện các vấn đề về nội dung và thực hiện sửa đổi hoặc loại bỏ.

- Đảm bảo URL được chuẩn hóa, tránh các phiên bản khác nhau của cùng một trang (ví dụ: http:// và https://, có hoặc không có www).

- Tối ưu hóa cấu hình URL trên CMS để tránh tạo URL động với tham số không cần thiết.

- Thêm thẻ rel=canonical vào phần

4. Crawl Budget bị lãng phí

Nguyên nhân:

- Googlebot tiêu tốn tài nguyên để thu thập các trang không quan trọng hoặc không cần lập chỉ mục.

- Trang chứa nội dung chất lượng thấp hoặc ít giá trị.

Cách khắc phục:

- Đánh dấu các trang không cần thiết bằng thẻ meta

noindex. - Sử dụng sitemap XML để hướng dẫn Googlebot tập trung vào các trang quan trọng.

- Dọn dẹp các liên kết nội bộ không cần thiết để tránh điều hướng Googlebot đến các khu vực không liên quan.

- Đánh dấu các trang không cần thiết bằng thẻ meta

Tương lai và xu hướng phát triển của Googlebot

Sự phát triển của Googlebot đã tạo ra các tiêu chuẩn mới mà các website cần tuân thủ để đảm bảo khả năng hiển thị và hiệu quả trong chiến lược SEO. Từ việc xử lý nội dung JavaScript phức tạp, hỗ trợ dữ liệu đa phương tiện, đến ưu tiên các tiêu chuẩn bảo mật và di động, Googlebot ngày càng trở nên mạnh mẽ và tinh vi hơn. Việc hiểu rõ xu hướng phát triển của Googlebot không chỉ giúp các nhà quản trị website thích nghi với những thay đổi mà còn tối ưu hóa nội dung và cấu trúc để duy trì hoặc cải thiện thứ hạng trong kết quả tìm kiếm.

Nội dung dưới đây sẽ tập trung phân tích chi tiết về sự tiến hóa của Googlebot, vai trò của trí tuệ nhân tạo trong các hoạt động thu thập dữ liệu, và tầm quan trọng của việc cập nhật website để đáp ứng các tiêu chuẩn mới mà Googlebot đề ra.

Sự thay đổi của Googlebot theo thời gian

Googlebot liên tục tiến hóa để đáp ứng những thay đổi trong công nghệ và nhu cầu tìm kiếm của người dùng. Ban đầu, Googlebot được thiết kế chủ yếu để thu thập nội dung văn bản tĩnh. Tuy nhiên, khi công nghệ web ngày càng phát triển, Googlebot đã được nâng cấp để hỗ trợ các tính năng phức tạp hơn, đảm bảo hiệu suất cao và khả năng lập chỉ mục chính xác.

- Xử lý JavaScript: Trước đây, các trang web sử dụng JavaScript thường không được thu thập hoặc lập chỉ mục đúng cách. Googlebot hiện nay sử dụng phiên bản Chromium mới nhất để kết xuất trang, đảm bảo nội dung động được xử lý đầy đủ.

- Hỗ trợ giao thức bảo mật: Việc ưu tiên các trang HTTPS là một bước tiến quan trọng, giúp nâng cao tiêu chuẩn bảo mật của các website. Các website sử dụng HTTP có nguy cơ bị xếp hạng thấp hơn.

- Ưu tiên di động (Mobile-First Indexing): Với sự gia tăng của người dùng di động, Googlebot đã chuyển trọng tâm từ phiên bản desktop sang phiên bản di động của các trang web. Điều này đòi hỏi website phải tối ưu hóa giao diện và hiệu suất trên thiết bị di động.

- Cải tiến hiệu quả crawl budget: Googlebot ngày càng thông minh hơn trong việc phân bổ tài nguyên thu thập dữ liệu, tập trung vào các trang có giá trị cao, giảm thiểu việc truy cập vào các trang kém chất lượng hoặc không liên quan.

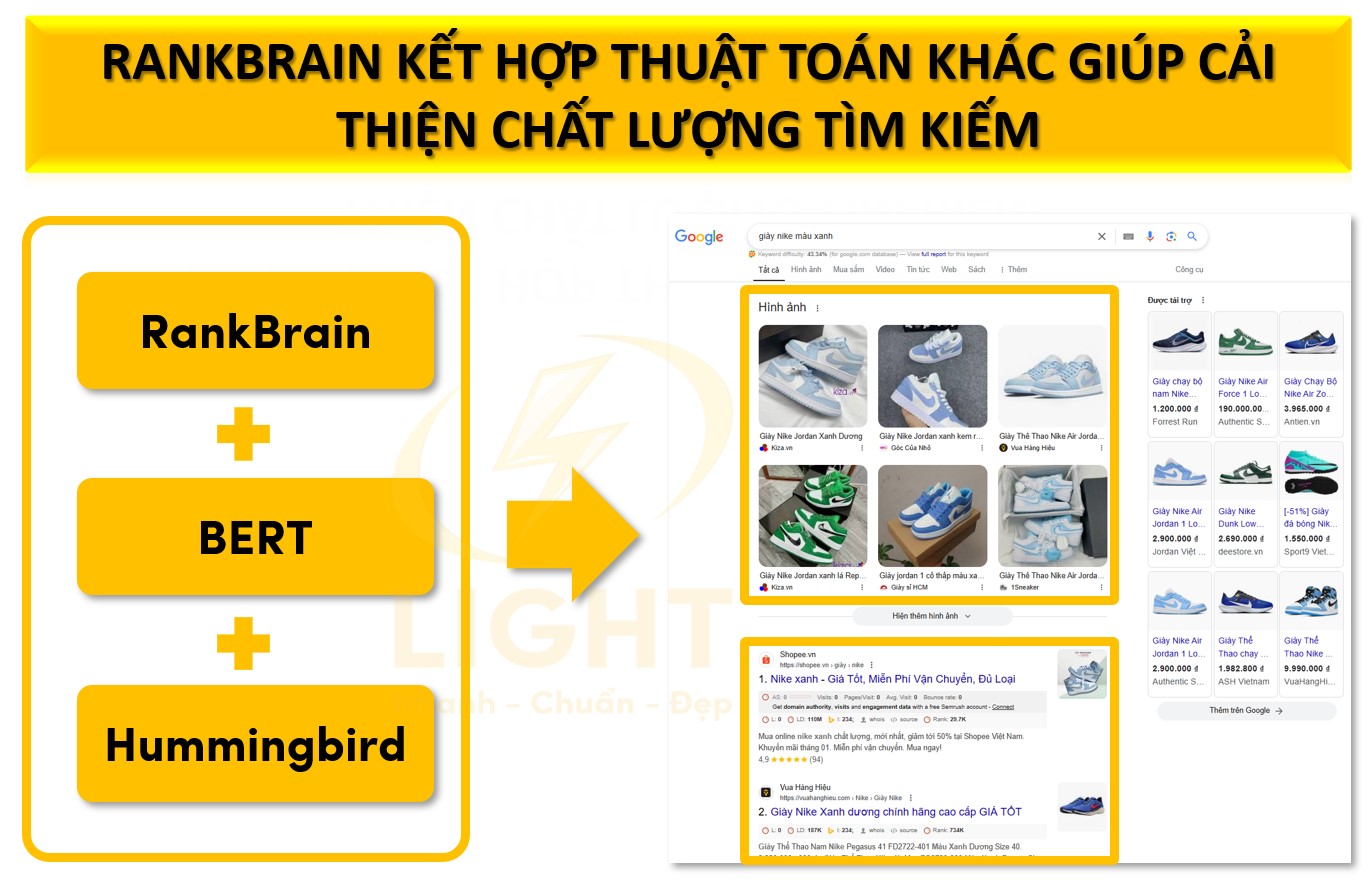

Googlebot và trí tuệ nhân tạo (AI) trong thuật toán tìm kiếm

Sự tích hợp trí tuệ nhân tạo vào Googlebot đã mang lại những bước tiến lớn trong việc thu thập và hiểu nội dung trên các trang web. AI không chỉ cải thiện khả năng lập chỉ mục mà còn giúp Googlebot nhận diện và xếp hạng nội dung chính xác hơn. Nếu muốn website có thứ hạng cao hơn, trước tiên bạn cần hiểu thuật toán Google là gì và cách nó đánh giá nội dung.

- Xử lý ngôn ngữ tự nhiên (NLP): Googlebot sử dụng AI để hiểu ngữ nghĩa của nội dung thay vì chỉ dựa vào từ khóa. Điều này cho phép nó nhận diện ngữ cảnh, ý định tìm kiếm và mối quan hệ giữa các chủ đề.

- Nhận diện nội dung đa phương tiện: Googlebot có khả năng xử lý hình ảnh, video và nội dung âm thanh thông qua các công nghệ học sâu. Điều này giúp các nội dung đa phương tiện được lập chỉ mục và xuất hiện trong kết quả tìm kiếm liên quan.

- Tối ưu hóa crawl budget thông qua AI: Trí tuệ nhân tạo giúp phân tích dữ liệu để xác định các trang có giá trị cao, tập trung vào nội dung quan trọng và giảm thời gian thu thập dữ liệu trên các trang không liên quan.

- Phát hiện nội dung không đáng tin cậy: AI hỗ trợ Googlebot trong việc nhận diện các nội dung vi phạm nguyên tắc của Google, chẳng hạn như spam, thông tin sai lệch hoặc nội dung sao chép.

Tầm quan trọng của việc cập nhật để đáp ứng tiêu chuẩn mới của Googlebot

Để đảm bảo rằng website luôn được Googlebot thu thập và lập chỉ mục hiệu quả, việc cập nhật và tối ưu hóa các yếu tố kỹ thuật và nội dung là cần thiết. Googlebot liên tục cải tiến tiêu chuẩn, đòi hỏi các nhà quản trị website phải thích nghi với những thay đổi này.

- Cập nhật công nghệ web: Website cần tích hợp các công nghệ hiện đại như AMP (Accelerated Mobile Pages), Progressive Web Apps (PWAs) để đáp ứng các tiêu chuẩn về tốc độ và hiệu suất.

- Tối ưu hóa tốc độ tải trang: Googlebot ưu tiên các trang tải nhanh, với thời gian phản hồi máy chủ dưới 200ms. Việc sử dụng nén GZIP, tối ưu hóa hình ảnh và giảm thiểu mã không cần thiết là các biện pháp bắt buộc.

- Dữ liệu có cấu trúc (Structured Data): Sử dụng schema.org để cung cấp ngữ cảnh rõ ràng về nội dung trên website, giúp Googlebot hiểu và hiển thị thông tin tốt hơn trong kết quả tìm kiếm.

- Tăng cường bảo mật: Website cần triển khai HTTPS, bảo vệ người dùng khỏi các cuộc tấn công và tăng độ tin cậy với Googlebot.

- Liên tục cập nhật nội dung: Nội dung cần được làm mới thường xuyên để duy trì sự phù hợp với ý định tìm kiếm của người dùng. Các bài viết cũ nên được cập nhật với dữ liệu mới, đảm bảo giá trị liên tục.

- Tuân thủ nguyên tắc E-E-A-T: Website cần thể hiện chuyên môn, kinh nghiệm, độ uy tín và tính đáng tin cậy trong mọi nội dung, giúp tăng thứ hạng trong kết quả tìm kiếm.

Việc đảm bảo website luôn đáp ứng các tiêu chuẩn mới không chỉ giúp tối ưu hóa hiệu suất thu thập dữ liệu của Googlebot mà còn cải thiện trải nghiệm người dùng và nâng cao vị trí trong kết quả tìm kiếm.

Cách kiểm tra xem Googlebot đã truy cập website của mình chưa?

Việc xác định xem Googlebot đã truy cập website của bạn hay chưa là một bước quan trọng để đảm bảo nội dung được lập chỉ mục đúng cách, cải thiện khả năng hiển thị trên kết quả tìm kiếm. Điều này đặc biệt cần thiết với các website có cấu trúc phức tạp, sử dụng nhiều nội dung động hoặc gặp phải các vấn đề kỹ thuật có thể hạn chế khả năng thu thập dữ liệu. Nếu bạn chưa biết website là gì, hãy tìm hiểu ngay để hiểu cách Google lập chỉ mục và xếp hạng nội dung của trang web.

Googlebot hoạt động bằng cách quét qua mã nguồn, đọc các tệp như robots.txt và sitemap, sau đó thu thập nội dung từ các URL mà nó có quyền truy cập. Tuy nhiên, các vấn đề như lỗi máy chủ, chặn truy cập từ tệp robots.txt, hoặc các lỗi trong mã nguồn có thể ngăn cản Googlebot thực hiện nhiệm vụ này một cách hiệu quả. Sử dụng các phương pháp kiểm tra chính xác, từ phân tích nhật ký máy chủ, sử dụng Google Search Console, đến tận dụng các công cụ bên thứ ba, là cách tối ưu để xác minh hoạt động của Googlebot trên website.

1. Kiểm tra nhật ký máy chủ (Server Log Files)

Nhật ký máy chủ là nguồn dữ liệu trực tiếp và chi tiết nhất để xác định Googlebot đã truy cập website hay chưa. Googlebot sẽ để lại dấu vết dưới dạng user-agent hoặc địa chỉ IP trong các yêu cầu HTTP được ghi lại.

Phân tích nhật ký máy chủ

Truy cập các tệp nhật ký thường được lưu trữ tại thư mục/var/log/hoặc trên giao diện quản trị hosting (cPanel, Plesk). Tìm kiếm các dòng chứa user-agent "Googlebot".Ví dụ dòng nhật ký mẫu:

66.249.66.1 - - [10/Jan/2025:10:35:22 +0000] "GET /light-page HTTP/1.1" 200 1234 "-" "Googlebot/2.1 (+http://www.google.com/bot.html)"Xác minh địa chỉ IP Googlebot

Các bot giả mạo có thể tự nhận dạng là Googlebot. Để đảm bảo tính chính xác, cần kiểm tra địa chỉ IP thông qua DNS ngược:- Dùng lệnh

host [IP-address]trên terminal hoặc công cụ DNS lookup để tra cứu tên miền. - Kết quả trả về phải thuộc các dải địa chỉ IP chính thức của Google, ví dụ

crawl-[ip]-googlebot.com. - Xác thực lần cuối bằng cách tra cứu ngược để đảm bảo tên miền trả về khớp với IP.

- Dùng lệnh

Lợi ích của phương pháp này

Cung cấp dữ liệu chi tiết về tần suất truy cập, thời gian cụ thể, các URL được truy cập, và mã phản hồi HTTP.

2. Sử dụng Google Search Console

Google Search Console là công cụ chính thức và trực quan để kiểm tra hoạt động thu thập dữ liệu của Googlebot trên website.

URL Inspection Tool

- Nhập URL cụ thể vào ô kiểm tra.

- Xem các thông tin chi tiết như:

- Ngày Googlebot thu thập dữ liệu gần nhất.

- Trạng thái lập chỉ mục.

- Nội dung được hiển thị khi Googlebot truy cập (bao gồm cả HTML, JavaScript).

Crawl Stats Report

- Truy cập mục "Crawl Stats" trong phần cài đặt.

- Báo cáo cung cấp:

- Tổng số yêu cầu thu thập dữ liệu từ Googlebot.

- Loại Googlebot sử dụng (Mobile, Desktop).

- Dung lượng dữ liệu tải xuống và thời gian phản hồi của máy chủ.

- Phân tích các mẫu truy cập thường xuyên vào URL cụ thể để xác nhận các trang quan trọng đã được quét.

3. Phân tích hoạt động truy cập tệp robots.txt

Tệp robots.txt thường là điểm khởi đầu khi Googlebot truy cập một website. Googlebot sẽ gửi yêu cầu GET tới tệp này để xác định các quy tắc truy cập.

Kiểm tra yêu cầu tệp robots.txt trong nhật ký máy chủ

Ví dụ dòng nhật ký truy cập tệp robots.txt bởi Googlebot:66.249.64.123 - - [10/Jan/2025:12:00:00 +0000] "GET /robots.txt HTTP/1.1" 200 124 "-" "Googlebot/2.1 (+http://www.google.com/bot.html)"Phân tích nội dung tệp robots.txt

Đảm bảo không chặn Googlebot truy cập các URL cần thiết bằng các chỉ thị như:User-agent: Googlebot Disallow: /private/Sử dụng báo cáo Google Search Console

Kiểm tra mục "Test robots.txt" để xác nhận Googlebot có thể truy cập đúng các URL mong muốn.

4. Sử dụng công cụ phân tích bên thứ ba

Các công cụ như Screaming Frog, Ahrefs, và SEMrush cung cấp khả năng kiểm tra và phân tích hoạt động thu thập dữ liệu của Googlebot.

Screaming Frog

- Sử dụng chức năng Log File Analyzer để tải lên tệp nhật ký máy chủ.

- Lọc các yêu cầu từ Googlebot và phân tích:

- Tần suất truy cập.

- Các URL không truy cập.

- Các lỗi HTTP gặp phải.

Ahrefs

Cung cấp báo cáo Site Audit chi tiết về các URL được Googlebot quét, trạng thái lập chỉ mục, và các vấn đề chặn truy cập. Công cụ này cũng phân tích dữ liệu robots.txt và các thẻ meta robots để xác định các vấn đề kỹ thuật.SEMrush

- Sử dụng tính năng Audit Log File để phân tích dữ liệu truy cập từ Googlebot.

- Kết hợp với báo cáo Technical SEO để tối ưu hóa cấu trúc website, tốc độ tải trang và trải nghiệm người dùng trên các thiết bị.

5. Tạo URL kiểm tra chuyên biệt

Tạo một trang duy nhất không liên kết từ bất kỳ URL nào khác, sau đó theo dõi xem Googlebot có truy cập trang này không.

Phương pháp thực hiện

- Tạo một trang HTML thử nghiệm với nội dung đặc biệt.

- Gửi URL này qua Google Search Console bằng công cụ "Request Indexing". Khi bạn gửi một liên kết để lập chỉ mục trong Google Search Console, điều đầu tiên cần hiểu là URL là gì và nó có đúng chuẩn không.

- Theo dõi nhật ký máy chủ hoặc kiểm tra trạng thái lập chỉ mục trong Google Search Console để xác nhận.

Lợi ích

Đây là cách trực tiếp để xác định xem Googlebot đã thu thập dữ liệu nội dung mới hay chưa.

Các phương pháp trên đảm bảo việc kiểm tra hoạt động của Googlebot không chỉ chính xác mà còn cung cấp góc nhìn toàn diện về hiệu suất truy cập và lập chỉ mục.

Thiết kế website chuẩn SEO cần tối ưu như thế nào để Googlebot dễ dàng lập chỉ mục?

Để Googlebot có thể dễ dàng thu thập và lập chỉ mục, một website cần được thiết kế tuân thủ các nguyên tắc tối ưu hóa chuẩn SEO. Các yếu tố cần tập trung bao gồm cấu trúc website, tốc độ tải trang, khả năng truy cập, nội dung chất lượng, và việc sử dụng công nghệ hỗ trợ hiện đại. Nếu là một website mới, điều đầu tiên cần cân nhắc là thiết kế website chuẩn SEO là gì và các yếu tố tối ưu cần thiết.

1. Cấu trúc website rõ ràng và dễ hiểu

- Tổ chức nội dung logic: Website cần có cấu trúc phân cấp hợp lý, từ trang chủ đến các danh mục chính, trang con. Điều này giúp Googlebot dễ dàng theo dõi và hiểu mối quan hệ giữa các trang.

- Sử dụng breadcrumb: Breadcrumb giúp điều hướng rõ ràng cho cả người dùng và Googlebot, cung cấp ngữ cảnh vị trí của một trang trong cấu trúc tổng thể.

- Tạo sitemap XML: Sitemap XML là bản đồ chỉ dẫn cho Googlebot, giúp nó nhanh chóng thu thập tất cả các URL quan trọng trên website. Đảm bảo sitemap luôn cập nhật và không chứa liên kết lỗi.

- Liên kết nội bộ: Tăng cường liên kết nội bộ giữa các trang, sử dụng anchor text mô tả chính xác nội dung của liên kết. Tránh liên kết hỏng hoặc trùng lặp.

2. Tối ưu hóa tốc độ tải trang

- Giảm kích thước tệp: Sử dụng nén GZIP cho các tệp HTML, CSS, JavaScript để giảm dung lượng tải xuống. Theo nghiên cứu từ Web Performance Working Group của W3C (2023) trong "Web Performance Impact on Crawl Budget", việc tối ưu hóa tốc độ tải trang qua các kỹ thuật nén dữ liệu đã được xác minh qua các thử nghiệm độc lập. Nghiên cứu chỉ ra rằng việc áp dụng GZIP và các thuật toán nén hiện đại giúp giảm kích thước tệp một cách hiệu quả, từ đó tăng tốc độ tải trang và cải thiện trải nghiệm người dùng.

- Tối ưu hình ảnh: Sử dụng định dạng hình ảnh hiện đại như WebP, nén hình ảnh mà không làm giảm chất lượng. Kích hoạt lazy loading cho các hình ảnh không hiển thị trong khung nhìn đầu tiên.

- Tối ưu hóa mã nguồn: Loại bỏ mã không cần thiết, giảm thiểu CSS và JavaScript. Sử dụng công cụ như Lighthouse để phát hiện và khắc phục các vấn đề liên quan đến hiệu suất.

- Giảm thời gian phản hồi máy chủ: Đảm bảo thời gian phản hồi dưới 200ms bằng cách sử dụng dịch vụ hosting chất lượng cao và tối ưu hóa cơ sở dữ liệu.

3. Đảm bảo khả năng truy cập và lập chỉ mục

- Robots.txt: Kiểm tra và cấu hình tệp robots.txt để đảm bảo không chặn Googlebot khỏi các khu vực quan trọng của website. Sử dụng công cụ “Kiểm tra tệp robots.txt” trong Google Search Console để xác minh.

- Thẻ meta robots: Sử dụng thẻ meta robots để kiểm soát việc lập chỉ mục của các trang không cần thiết, chẳng hạn như trang admin hoặc trang nội dung trùng lặp.

- Tránh lỗi 404 và 500: Kiểm tra thường xuyên để phát hiện và khắc phục các URL lỗi. Thiết lập chuyển hướng 301 khi xóa trang hoặc thay đổi URL.

- Mobile-First Indexing: Đảm bảo phiên bản di động của website được tối ưu hóa đầy đủ vì Googlebot ưu tiên lập chỉ mục dựa trên giao diện di động.

4. Tối ưu nội dung và từ khóa

- Tạo nội dung chất lượng cao: Nội dung phải đáp ứng ý định tìm kiếm của người dùng, sử dụng từ khóa phù hợp và cung cấp thông tin hữu ích, chính xác.

- Sử dụng thẻ tiêu đề và mô tả: Tối ưu hóa thẻ tiêu đề (H1, H2, H3) và meta description để Googlebot dễ hiểu cấu trúc nội dung. Mỗi trang cần có tiêu đề độc nhất, chứa từ khóa chính.

- Sử dụng dữ liệu có cấu trúc (Structured Data): Áp dụng schema.org để cung cấp ngữ cảnh rõ ràng về nội dung, giúp tăng khả năng hiển thị trên kết quả tìm kiếm dạng rich snippets.

5. Đảm bảo bảo mật và trải nghiệm người dùng

- HTTPS: Sử dụng giao thức HTTPS để đảm bảo an toàn cho người dùng và tăng tín hiệu xếp hạng.

- Trải nghiệm người dùng: Đảm bảo website dễ sử dụng, không có quảng cáo xâm nhập, và có giao diện thân thiện trên cả desktop và di động.

- Thời gian trên trang: Cải thiện thời gian người dùng ở lại trên trang bằng cách cung cấp nội dung hấp dẫn, giảm tỷ lệ thoát (bounce rate).

6. Kiểm tra và theo dõi thường xuyên

- Sử dụng Google Search Console: Kiểm tra hiệu suất thu thập dữ liệu, lỗi lập chỉ mục, và các vấn đề liên quan đến sitemap, robots.txt.

- Công cụ SEO: Sử dụng các công cụ như Screaming Frog, Ahrefs, hoặc SEMrush để phát hiện vấn đề kỹ thuật và tối ưu hóa toàn diện.

- Kiểm tra tương thích trình duyệt: Đảm bảo website hoạt động tốt trên mọi trình duyệt và thiết bị.

Bằng cách thực hiện các tối ưu hóa trên, website sẽ không chỉ đáp ứng các tiêu chuẩn của Googlebot mà còn cải thiện đáng kể hiệu quả SEO, giúp tăng khả năng tiếp cận và thứ hạng trong kết quả tìm kiếm.

Chi tiết: https://light.com.vn/minh-hm

Youtube: https://www.youtube.com/@minhhmchanel2340